QPSТюђжФўТЈљтЇЄ91% | УЁЙУ«»С║ЉTKEтЪ║С║јCilium eBPFТЈљтЇЄk8s ServiceТђДУЃй

ТгА

ТгА

тЅЇУеђ

Kubernetesти▓у╗ЈТѕљСИ║т«╣тЎеу«АуљєжбєтЪЪуџёС║Іт«ъТаЄтЄє№╝їУђїуйЉу╗юу│╗у╗ЪТў»KubernetesТаИт┐ЃжЃетѕє№╝їжџЈуЮђУХіТЮЦУХітцџуџёСИџтіАжЃеуй▓тюеKubernetes№╝їт»╣т«╣тЎеуйЉу╗юС╣ЪТЈљтЄ║С║єСИђС║ЏТќ░уџёжюђТ▒ѓ

1.ТђјС╣ѕТЈљтЇЄуйЉу╗юуџётЈ»УДѓТхІТђД№╝їserverlessу▒╗С║ДтЊЂУ»ЦжюђТ▒ѓт░цСИ║уфЂтЄ║

2.ТђјС╣ѕт░йтЈ»УЃйтЄЈт░Љт«╣тЎет╝ЋтЁЦуџёуйЉу╗юТђДУЃйТЇЪУђЌ

СИіУ┐░жюђТ▒ѓтє▓тЄ╗С║єiptables№╝їIPVSуГЅС╝ау╗Ъжў▓уЂФтбЎ№╝їУ┤ЪУййтЮЄУААтЎеТіђТю»сђѓС╣ЪС┐ЃСй┐ТѕЉС╗гТђЮУђЃт«╣тЎеуйЉу╗юУ«┐жЌ«жЊЙУи»УЃйтљдСИЇСЙЮУхќС║јУіѓуѓ╣№╝їУ┐ЏУђїу╝ЕуЪГт«╣тЎеУ«┐жЌ«жЊЙУи»№╝їТЈљтЇЄуйЉу╗юТђДУЃй

eBPFТў»СИђжА╣жЮЕтЉйТђДТіђТю»№╝їт«ЃтЈ»С╗ЦС╗ЦСИђуДЇт«ЅтЁеуџёТќ╣т╝ЈтюетєЁТаИСИГУ«Итцџhookуѓ╣ТЅДУАїуеІт║Ј№╝їУ»ЦжА╣ТіђТю»тЈ»у╝ќуеІУЃйтіЏт╝║№╝їт╣ХСИћС╣ЪТЌажюђу╗┤ТіцтєЁТаИТеАтЮЌ№╝їтЈ»у╗┤ТіцТђДтЦй№╝їУ»ЦжА╣ТіђТю»СИ║Т╗АУХ│СИіУ┐░жюђТ▒ѓТЈљСЙЏС║єтЈ»УЃйсђѓCilium[1]тѕЎТў»тЪ║С║јeBPFТіђТю»уџёт«╣тЎеуйЉу╗ют╝ђТ║љжА╣уЏ«№╝їТЈљСЙЏС║єуйЉу╗юС║њжђџ№╝їТюЇтіАУ┤ЪУййтЮЄУАА№╝їт«ЅтЁетњїтЈ»УДѓТхІТђДуГЅУДБтє│Тќ╣ТАѕ

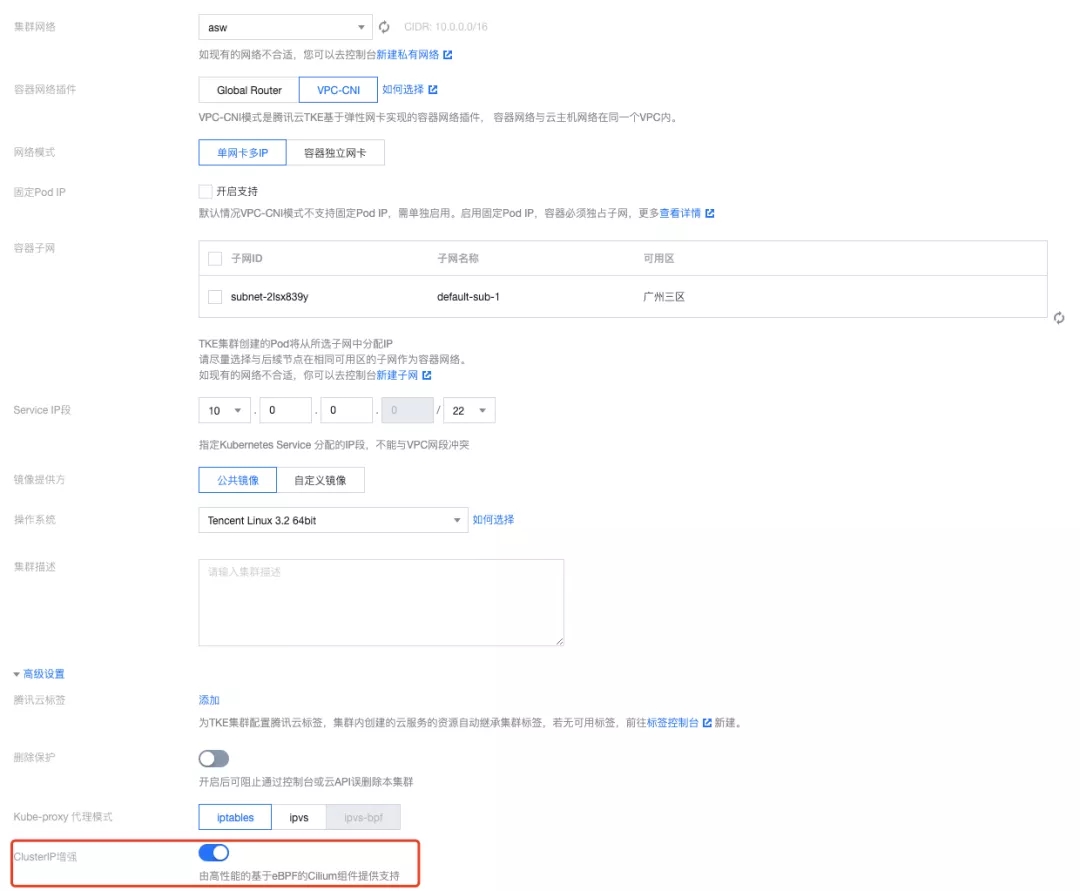

ућ▒ТГц№╝їУЁЙУ«»С║Љт«╣тЎеТюЇтіАTKEтЪ║С║јCiliumтњїeBPFт«ъуј░С║єуІгуФІуйЉтЇАТеАт╝ЈСИІуџёжФўТђДУЃйClusterIP ServiceТќ╣ТАѕсђѓTKEУЄ┤тіЏС║јТЈљСЙЏТЏ┤жФўТђДУЃйсђЂТЏ┤т«ЅтЁетњїТЏ┤ТўЊућеуџёт«╣тЎеуйЉу╗ю№╝їС╣ЪтЏаТГцС╝џСИЇТќГтЁ│Т│еCiliumуГЅтЅЇТ▓┐уџёт«╣тЎеуйЉу╗юТіђТю»Тќ╣ТАѕ№╝їтљју╗ГС╝џТјетЄ║ТЏ┤тцџТЏ┤т«їтќёуџёCiliumС║ДтЊЂтїќУЃйтіЏсђѓ

уІгуФІуйЉтЇАServiceТќ╣ТАѕ

TKEС║јтј╗т╣┤ТјетЄ║С║єТќ░СИђС╗Бт«╣тЎеуйЉу╗юТќ╣ТАѕ№╝їУ»ЦТќ╣ТАѕт«ъуј░С║єСИђСИфPodуІгтЇаСИђт╝ат╝╣ТђДуйЉтЇА№╝їСИЇтєЇу╗ЈУ┐ЄУіѓуѓ╣уйЉу╗ютЇЈУ««Таѕ№╝ѕdefault namespace№╝ЅсђѓУђїтйЊтЅЇуџёkube-proxyт«ъуј░ClusterIPуџёТќ╣ТАѕжЃйСЙЮУхќС║јтюеУіѓуѓ╣СЙДуџёуйЉу╗ютЇЈУ««ТаѕжЄїУ«Йуй«уЏИт║ћуџёiptablesУДётѕЎ№╝їС╣ЪтЏаТГцУ»ЦТќ╣ТАѕт»╣С║јуІгуФІуйЉтЇАТќ╣ТАѕСИЇтєЇжђѓућесђѓ

тЁХСИГСИђСИфУДБтє│Тќ╣ТАѕСЙ┐Тў»Cilium№╝їCiliumТЈљСЙЏС║єтЪ║С║јeBPFуџётю░тЮђУйгТЇбУЃйтіЏ№╝їС╗јУђїтЈ»Тћ»ТїЂClusterIP ServiceсђѓСйєтЁХтјЪућЪТќ╣ТАѕС╗ЁТћ»ТїЂveth pairтњїipvlan l3уџёТЋ░ТЇ«жЮб№╝їт╣ХСИЇТћ»ТїЂPodт«їтЁеСИЇу╗ЈУ┐ЄУіѓуѓ╣уйЉу╗ютЇЈУ««ТаѕуџёТЋ░ТЇ«жЮб№╝їтЏаТГцСИЇУЃйтјЪућЪУДБтє│уІгуФІуйЉтЇАClusterIPуџёУ«┐жЌ«жЌ«жбўсђѓ

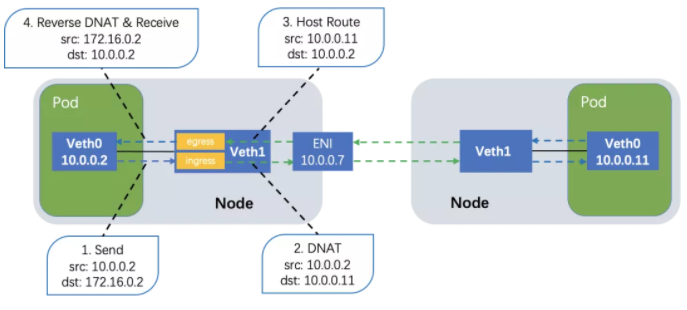

TKEућ▒ТГцт»╣CiliumтіаС╗ЦТћ╣жђа№╝їСй┐тЁХТћ»ТїЂС║єжЎцтјЪућЪТћ»ТїЂуџёvethтњїipvlan l3уџёуггСИЅуДЇТЋ░ТЇ«жЮбТќ╣ТАѕ№╝їтдѓтЏЙ№╝ѕтЂЄУ«ЙpodУ«┐жЌ«Service IPСИ║172.16.0.2№╝Ѕ№╝їТЋ░ТЇ«жЮбСИі№╝їт░єтјЪТюгТїѓУййтѕ░Уіѓуѓ╣СЙДуџёvethСИіуџёbpfуеІт║Ј№╝їТїѓУййтѕ░podтєЁуџёуІгуФІуйЉтЇА№╝ѕтљїТЌХС╣ЪТў»т╝╣ТђДуйЉтЇА№╝ЅСИі№╝їСй┐тЙЌPodуџёуйЉу╗юТіЦТќЄтюетЈЉтЄ║уџёТЌХтђЎтЂџDNAT№╝ѕуЏ«уџётю░тЮђУйгТЇб№╝Ѕ№╝їУђїтЏъТіЦТќЄтюеуйЉтЇАТјЦТћХуџёТЌХтђЎтЂџтЈЇтљЉDNAT№╝їС╗јУђїТћ»ТїЂClusterIPуџёУ«┐жЌ«сђѓУ»ЦТЋ░ТЇ«жЮбТќ╣ТАѕтЈ»СйюСИ║СИђСИфжђџућеТќ╣ТАѕжђѓжЁЇIpvlan l2сђЂSRIOVуГЅТЋ░ТЇ«жЮбтю║ТЎ»сђѓ

УђїТјДтѕХжЮбСИі№╝їт░єCiliumСИјTKEуџёVPC-CNIТеАт╝Ј№╝ѕтљФтЁ▒С║ФуйЉтЇАТеАт╝ЈтњїуІгуФІуйЉтЇАТеАт╝Ј№╝ЅТи▒т║джЏєТѕљ№╝їућеТѕиТЌажюђт»╣СИџтіАС╗БуаЂжђ╗УЙЉтЂџС╗╗СйЋС┐«Тћ╣№╝їтЇ│тЈ»Сй┐ућеCiliumуџётіЪУЃйуЅ╣ТђДсђѓ

ТђДУЃйт»╣Т»ћ

ТюгТќЄСй┐ућеwrkтиЦтЁит»╣CiliumуџёС║ДтЊЂтїќУДБтє│Тќ╣ТАѕУ┐ЏУАїС║єТђДУЃйтјІТхІ№╝їТхІУ»ЋС┐ЮУ»ЂClient PodтњїServer PodтѕєтИЃтюеСИЇтљїУіѓуѓ╣сђѓ

ТхІУ»Ћуј»тбЃ№╝џTKEжЏєуЙц№╝ї4СИфCVMУіѓуѓ╣№╝їжЁЇуй«СИ║Server S5.2XLARGE8№╝їClient S5.SMALL2сђѓ

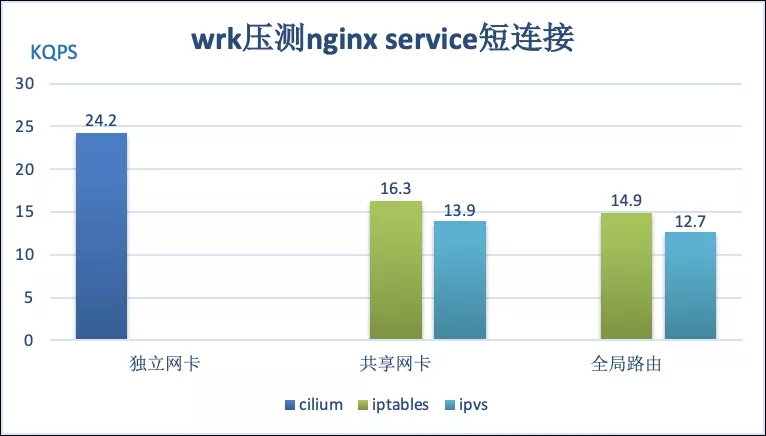

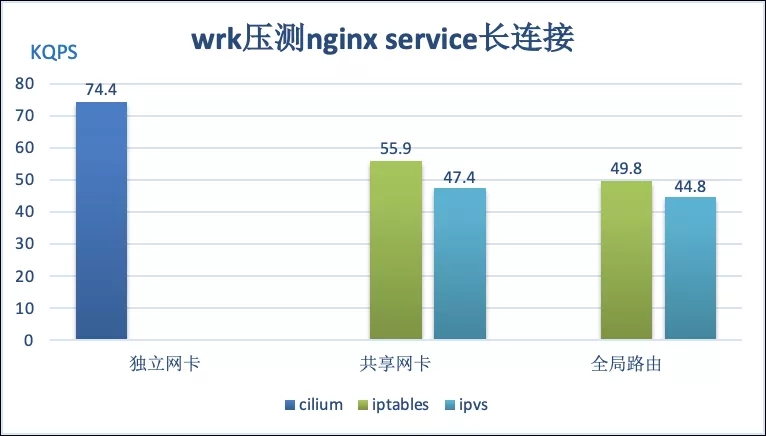

ТхІУ»ЋТЋ░ТЇ«УАеТўј№╝їтЪ║С║јCiliumуџёуІгуФІуйЉтЇАClusterIPУ«┐жЌ«Тќ╣ТАѕТђДУЃйТюђтЦйсђѓтюеуЪГУ┐ъТјЦтю║ТЎ»СИІ№╝їтЁХQPSуЏИТ»ћтЁ▒С║ФуйЉтЇАуџёiptablesтњїipvsТќ╣ТАѕТЈљтЇЄ48%тњї74%№╝їуЏИТ»ћтЁет▒ђУи»ућ▒уџёiptablesтњїipvsТќ╣ТАѕТЈљтЇЄС║є62%тњї91%сђѓтюежЋ┐У┐ъТјЦтю║ТЎ»СИІ№╝їтЁХQPSуЏИТ»ћтЁ▒С║ФуйЉтЇАуџёiptablesтњїipvsТќ╣ТАѕТЈљтЇЄС║є33%тњї57%№╝їУђїуЏИТ»ћтЁет▒ђУи»ућ▒уџёiptablesтњїipvsТќ╣ТАѕТЈљтЇЄС║є49%тњї66%сђѓiptablesуџёТђДУЃйУЙЃipvsТђДУЃйУЙЃтЦйТў»тЏаСИ║ТхІУ»Ћуј»тбЃСИГServiceТЋ░жЄЈУ┐ўСИЇтцЪтцџ№╝їipvsуџёС╝ўті┐тюеС║јтцДжЄЈServiceуџётю║ТЎ»сђѓ

С║ДтЊЂтїќУ┐ЄуеІСИГуџёуЏИтЁ│жЌ«жбў

TKEтЏбжўЪтюет«ъуј░CiliumС║ДтЊЂтїќУДБтє│Тќ╣ТАѕУ┐ЄуеІСИГ№╝їС╣ЪтЈЉуј░С║єCiliumжА╣уЏ«СИГСИђС║ЏжЌ«жбў№╝їуЏИт║ћуџёУДБтє│Тќ╣ТАѕтњїCiliumТћ»ТїЂТќ░ТЋ░ТЇ«жЮбТќ╣ТАѕт░єС║јУ┐ЉТЌЦС╗Цprуџётйбт╝ЈТЋ┤уљєТЈљС║цу╗ЎCiliumуцЙтї║сђѓ

уІгуФІуйЉтЇАТќ╣ТАѕСИІуџёClusterIPУЄфУ«┐жЌ«СИЇжђџ

С╗ЦСИіТќ╣ТАѕтЁХт«ъСИЇУЃйт«їтЁеУДБтє│ClusterIPУ«┐жЌ«жЌ«жбў№╝їтГўтюеСИђу▒╗уЅ╣Т«іуџётю║ТЎ»С╝џУ«┐жЌ«СИЇжђџсђѓУ┐Ўу▒╗тю║ТЎ»т░▒Тў»PodУ«┐жЌ«уџёClusterIP№╝їтЁХтљјуФ»тїЁТІгтЁХУЄфУ║ФсђѓУ┐Ўу▒╗тю║ТЎ»СИІ№╝їуІгуФІуйЉтЇАуџёPodтЈЉтЄ║уџёуйЉу╗юТіЦТќЄС╝џуЏ┤ТјЦтѕ░УЙЙIaaSт▒ѓ№╝їСИЇугдтљѕжбёТюЪсђѓ

ућ▒С║јуІгуФІуйЉтЇАPodтєЁ№╝їтЁХт«ътЈфТюЅСИцСИфуйЉу╗юУ«ЙтцЄ№╝џтЏъуј»У«ЙтцЄ№╝ѕlo№╝Ѕтњїт╝╣ТђДуйЉтЇА№╝їтЏаТГцСИђСИфу«ђтЇЋуџёТђЮУи»т░▒Тў»тюетЄ║ТіЦТќЄС╣ІтЅЇ№╝їт»╣УЄфУ«┐жЌ«ТхЂжЄЈ№╝їжђџУ┐Єbpf_redirectУ░Ѓућет░єТіЦТќЄуЏ┤ТјЦУйгтЈЉ№╝ѕredirect№╝Ѕтѕ░тЏъуј»№╝ѕlo№╝ЅУ«ЙтцЄсђѓтЪ║С║јТГц№╝їTKEтЏбжўЪС┐«Тћ╣С║єciliumуџёуЏИтЁ│bpfС╗БуаЂ№╝їТЈљСЙЏС║єСИђСИфУДБтє│Тќ╣ТАѕсђѓу╗ЈУ┐ЄТхІУ»Ћ№╝їУ»ЦТќ╣ТАѕтЈ»С╗ЦУДБтє│уІгуФІуйЉтЇАТќ╣ТАѕСИІуџёClusterIPУЄфУ«┐жЌ«жЌ«жбўсђѓ

CiliumтіаУййbpfуеІт║ЈуџётљЇтГЌу╝║тц▒

CiliumжА╣уЏ«уџётЈ»У░ЃУ»ЋТђДтГўтюеСИђСИфжЌ«жбў№╝їтЁХbpfуеІт║Јт╝ђтЈЉтЙЌТ»ћУЙЃТЌЕ№╝їт║Ћт▒ѓућеС║єтЙѕтцџУђЂуџётиЦтЁижЏє№╝їСЙІтдѓtc№╝їТЮЦтіаУййbpfС╗БуаЂсђѓ

УђЂуџёtcтЪ║С║јУђЂуџётєЁТаИуЅѕТюг(<4.15)У«ЙУ«Ауџё№╝їт«ЃтюетіаУййbpfуеІт║ЈТЌХ№╝їт░єbpfуеІт║ЈуџётљЇтГЌт┐йуЋЦС║є№╝їт»╝УЄ┤CiliumтіаУййуџёbpfуеІт║ЈжЃйТў»ТЌатљЇтГЌуџёсђѓУ┐Ўтй▒тЊЇС║єт»╣С╗БуаЂуџёуљєУДБ№╝їУ┐йУИфтњїУ░ЃУ»Ћсђѓ

т»╣ТГцTKEтЏбжўЪу╗ЊтљѕУЙЃТќ░уџётєЁТаИт»╣tcтиЦтЁиУ┐ЏУАїС║єС┐«ТГБ№╝їСй┐тЙЌт«ЃтіаУййbpfуеІт║ЈТЌХ№╝їС╝џТГБуА«уџёС╝атЁЦтљЇтГЌсђѓжђџУ┐ЄУ┐ЎтљЇтГЌ№╝їтЈ»С╗ЦТљъТИЁТЦџт«ъжЎЁУ┐љУАїуџёbpfтЄйТЋ░тЁиСйЊТў»тЊфСИђСИф№╝їС╗јУђїТЈљжФўCiliumуџётЈ»У░ЃУ»ЋТђДсђѓ

ућеТ│Ћ

ућ│У»иCiliumТћ»ТїЂClusterIPС║ДтЊЂтїќтєЁТхІт╝ђжђџтљј№╝їтѕЏт╗║TKEжЏєуЙцТЌХжФўу║ДУ«Йуй«СИГТЅЊт╝ђClusterIPтбът╝║тЇ│тЈ»№╝џ

Тђ╗у╗ЊСИјт▒ЋТюЏ

ТюгТќЄС╗Іу╗ЇС║єTKEтЏбжўЪт«ъуј░уџётЪ║С║јCiliumтњїeBPFуџёуІгуФІуйЉтЇАТеАт╝ЈСИІжФўТђДУЃйClusterIP serviceТќ╣ТАѕ№╝їУ»ЦТќ╣ТАѕуЏИТ»ћтйЊтЅЇтЪ║С║јiptablesтњїipvsуџёС╝ау╗ЪуйЉу╗юТќ╣ТАѕтцДжЄЈуџёТЈљтЇЄС║єТђДУЃй№╝ѕ33%-91%№╝Ѕсђѓ

ТўЙуёХ№╝їCiliumТЈљСЙЏуџёУЃйтіЏУ┐ўСИЇТГбС║јТГц№╝їтЁХтЪ║С║јeBPFУ┐ЎжА╣жЮЕтЉйТђДуџёТіђТю»№╝їУ┐ўТЈљСЙЏС║єт«ЅтЁесђЂтЈ»УДѓТхІТђДсђЂQoSуГЅТќ╣жЮбуџёУЃйтіЏ№╝їУђїТЈљСЙЏТЏ┤жФўТђДУЃйсђЂТЏ┤т«ЅтЁетњїТЏ┤ТўЊућеуџёт«╣тЎеуйЉу╗юТГБТў»TKEуџёТюЇтіАуЏ«ТаЄ№╝їтЏаТГц№╝їтљју╗ГTKEт░єС╝џуД»ТъЂтЈѓСИјCiliumуцЙтї║№╝їСИјуцЙтї║СИђжЂЊтЁ▒тљїТјетЄ║ТЏ┤т╝║тцДсђЂТЏ┤т«їтќёуџёт«╣тЎеуйЉу╗юУЃйтіЏсђѓ

тЈѓУђЃУхёТќЎ

[1] CiliumжА╣уЏ«т«ўуйЉ:сђљhttps://cilium.io/сђЉ

[2] eBPFС╗Іу╗ЇтњїтЈѓУђЃТїЄтЇЌ:сђљhttps://docs.cilium.io/en/v1.10/bpf/сђЉ

[3] Kubernetes Service:сђљhttps://kubernetes.io/docs/concepts/services-networking/service/сђЉ

[4] УЁЙУ«»С║Љт«╣тЎеТюЇтіАTKEТјетЄ║Тќ░СИђС╗БжЏХТЇЪУђЌт«╣тЎеуйЉу╗ю

- тдѓСйЋтюеiPhoneСИіт┐ФжђЪТЅЙтѕ░TikTokтЦйтЈІ№╝ЪУ┐ЎСИцСИфу«ђтЇЋТќ╣Т│ЋУй╗ТЮЙТљът«џ№╝Ђ

- тЏйтєЁућеТѕитдѓСйЋСИІУййтњїСй┐ућеTikTok№╝ЪУІ╣Тъютњїт«ЅтЇЊУ«ЙтцЄТюЅСИЇтљїУдЂТ▒ѓтљЌ№╝Ъ

- СИ╗У┤дтЈиСИјтЅ»У┤дтЈитдѓСйЋжЁЇтљѕуЏ┤ТњГ№╝ЪТЈГуДўтцДтЈиу▓ЅСИЮтбъжЋ┐уџёуДўУ»ђ№╝Ђ

- TikTokУй»Уи»ућ▒уюЪуџёТюЅт┐ЁУдЂтљЌ№╝ЪтдѓСйЋУ«ЕСйауџёуйЉжђЪТ»ћтѕФС║║т┐Ф№╝Ъ

- тЏйтєЁТЌаТ│ЋТГБтИИСй┐ућеTikTok№╝ЪУ┐ЎС║ЏУ«Йуй«СйауЪЦжЂЊС║єтљЌ№╝Ъ

- TikTokтИдУ┤ДТЮЃжЎљтдѓСйЋућ│У»и№╝ЪтЋєтЊЂТЕ▒уфЌУй╗ТЮЙтЈўуј░№╝їСйатГдС╝џС║єтљЌ№╝Ъ

- СИ║С╗ђС╣ѕтЏйтєЁтй▒УДєтЅфУЙЉСИЇУхџжњ▒С║є№╝ЪTikTokУЃйтљдТѕљСИ║СйауџёСИІСИђСИфУхџжњ▒тѕЕтЎе№╝Ъ

- TikTokуЪГУДєжбЉтИдУ┤ДТђјТаиТЅЇУЃйТюѕУхџ20СИЄ№╝Ът░ЈтЏбжўЪтдѓСйЋт┐ФжђЪт«ъуј░жФўТћХуЏі№╝Ъ