ТЈГуДўTDSQL-AтѕєтИЃт╝ЈТЅДУАїТАєТъХ№╝џУДБТћЙOLAPтЁ│УЂћтѕєТъљТЪЦУ»бТђДУЃйуЊХжбѕ

ТгА

ТгА

тюеРђютЏйС║ДТЋ░ТЇ«т║ЊуАгТаИТіђТю»Т▓ЎжЙЎ-TDSQL-AТіђТю»ТЈГуДўРђЮу│╗тѕЌтѕєС║ФСИГ№╝ї5СйЇУЁЙУ«»С║ЉТіђТю»тцДтњќтѕєтѕФС╗јТЋ┤СйЊТіђТю»ТъХТъёсђЂтѕЌт╝ЈтГўтѓетЈіуЏИтЁ│ТЅДУАїС╝ўтїќсђЂжЏєуЙцТЋ░ТЇ«С║цС║њТђ╗у║┐сђЂтѕєтИЃт╝ЈТЅДУАїТАєТъХУ«ЙУ«АтЈіС╝ўтїќуГќуЋЦсђЂС╗ЦтЈітљЉжЄЈтїќТЅДУАїт╝ЋТЊјуГЅтцџТќ╣жЮбт»╣TDSQL-AУ┐ЏУАїС║єТи▒тЁЦУДБУ»╗сђѓ

ТюгТюЪтИдТЮЦС║єу│╗тѕЌтѕєС║ФСИГУЁЙУ«»С║ЉТЋ░ТЇ«т║ЊжФўу║ДтиЦуеІтИѕт╝атђЕУђЂтИѕСИ╗жбўСИ║РђюTDSQL-AтѕєтИЃт╝ЈТЅДУАїТАєТъХУ«ЙУ«АтЈіС╝ўтїќуГќуЋЦРђЮуџётѕєС║ФуџёТќЄтГЌуЅѕсђѓТ▓АТюЅтљгуЏ┤ТњГуџёт░ЈС╝ЎС╝┤№╝їтЈ»УдЂУ«цуюЪтЂџугћУ«░тЋд№╝Ђ

СйюСИ║жбєтЁѕуџётѕєТъљтъІТЋ░ТЇ«т║Њ№╝їTDSQL-AТў»УЁЙУ«»ждќТгЙтѕєтИЃт╝ЈтѕєТъљтъІТЋ░ТЇ«т║Њ№╝їжЄЄућетЁет╣ХУАїТЌатЁ▒С║ФТъХТъё№╝їтЁиТюЅУЄфуаћтѕЌт╝ЈтГўтѓет╝ЋТЊј№╝їТћ»ТїЂУАїтѕЌТиитљѕтГўтѓе№╝їжђѓт║ћС║јТхижЄЈOLAPтЁ│УЂћтѕєТъљТЪЦУ»бтю║ТЎ»сђѓт«ЃУЃйтцЪТћ»ТїЂ2000тЈ░уЅЕуљєТюЇтіАтЎеС╗ЦСИіуџёжЏєуЙцУДёТеА№╝їтГўтѓет«╣жЄЈУЃйУЙЙтѕ░тЇЋТЋ░ТЇ«т║Њт«ъСЙІуЎЙPу║Дсђѓ

СИђсђЂТЅДУАїТАєТъХТђ╗СйЊУ«ЙУ«А

1.1 TDSQL-AТъХТъё

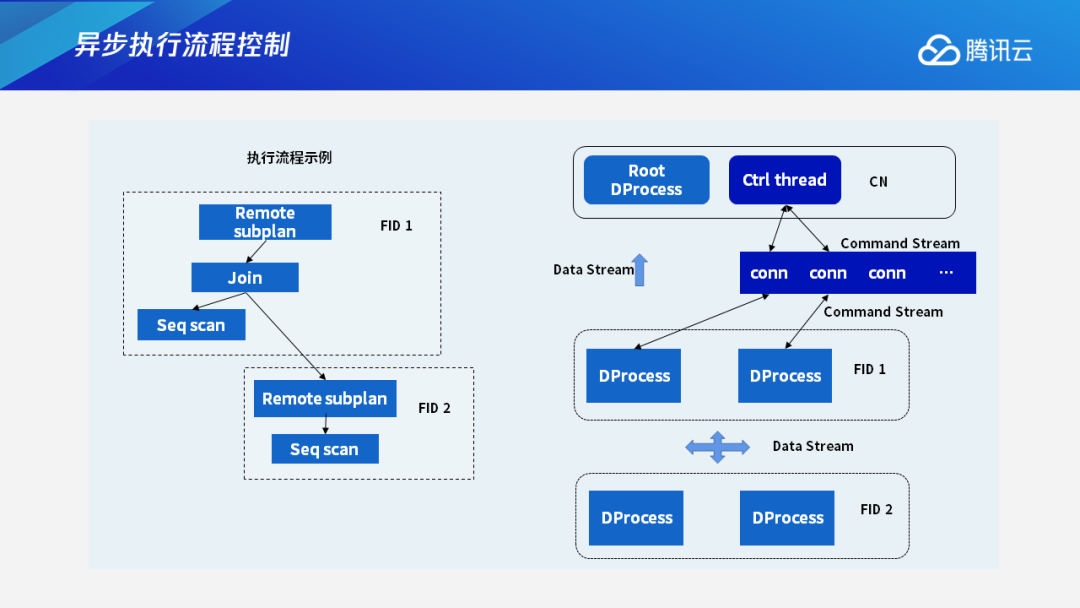

ждќтЁѕС╗Іу╗ЇTDSQL-AуџёТђ╗СйЊТъХТъё№╝їтїЁТІгСИіт▒ѓуџётЇЈУ░ЃУіѓуѓ╣CNсђЂGTMС║ІтіАу«АуљєтЎесђЂСИГжЌ┤уџёТЋ░ТЇ«С║цС║њТђ╗у║┐FNсђЂС╗ЦтЈіСИІТќ╣уџёТЋ░ТЇ«Уіѓуѓ╣DNсђѓСИ╗УдЂС╗Іу╗ЇуџёТў»тЇЈУ░ЃУіѓуѓ╣CNтњїТЋ░ТЇ«Уіѓуѓ╣DNуџёуЏИтЁ│тєЁт«╣№╝їтїЁТІгућеТѕиуџёТЪЦУ»бТђјС╣ѕтюеCNтњїDNСИіТЅДУАїсђЂТюђтљјтдѓСйЋУ┐ћтЏъу╗ЊТъюу╗ЎућеТѕиуГЅжЌ«жбўсђѓ

TDSQL-AжЄЄућеMPPТъХТъё№╝їтЁХуЅ╣ТђДТў»share-nothing№╝їТЋ░ТЇ«тѕєТЋБтюетцџСИфDNСИі№╝їТїЅуЁДСИЇтљїуџётѕєтИЃжћ«тѕєтИЃ№╝їт╣ХСИћСИЇтљїуџёУАетЈ»С╗ЦУЄфт«џС╣ЅСИЇтљїуџётѕєтИЃжћ«сђѓтдѓТъюCNТћХтѕ░С║єСИђТЮАТЪЦУ»б№╝їт«ЃС╝џт░єУ┐ЎСИфС╗╗тіАтѕєТЋБтѕ░тцџСИфDNСИіт╣ХУАїТЅДУАї№╝їС╗јУђїТЈљжФўТЅДУАїТЋѕујЄ№╝їТюђтљјCNУјитЙЌDNт╣ХУАїТЅДУАїуџёТюђтљју╗ЊТъю№╝їТ▒ЄТђ╗С╣ІтљјтєЇУ┐ћтЏъу╗Ўт«бТѕиуФ»сђѓ

1.2 тјЪтѕєтИЃт╝ЈТЅДУАїТАєТъХ

У┐ЎжЄїтЁѕУ»┤ТўјСИђСИІТѕЉС╗гуџётјЪтѕєтИЃт╝ЈТЅДУАїТАєТъХСИђСИфТюђСИ╗УдЂуџёжЌ«жбўсђѓСИІтЏЙТў»СИђСИфу«ђтЇЋуџёJoinТЪЦУ»б№╝їтдѓТъюJoinТЪЦУ»бТГБтЦйТў»тюеУ┐ЎСИфУАеуџётѕєтИЃжћ«СИіУ┐ЏУАїJoin№╝їтѕЎСИЇТХЅтЈіТЋ░ТЇ«уџёжЄЇтѕєтИЃ№╝їтЈ»С╗ЦуЏ┤ТјЦтюеТ»ЈСИфDNУіѓуѓ╣СИіУ┐ЏУАїJoin№╝їDNуџёу╗ЊТъюТ▒ЄТђ╗УхиТЮЦт░▒Тў»Тюђу╗ѕуџёТЪЦУ»бу╗ЊТъю№╝їУ┐ЎТў»ТюђуљєТЃ│уџёТЃЁтєхсђѓ

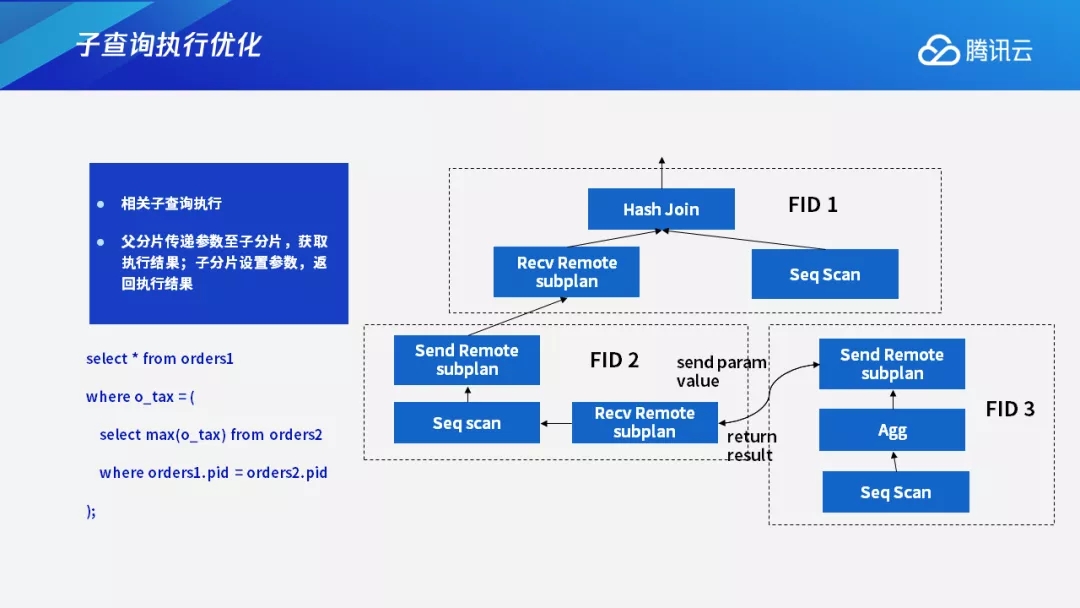

Сйєт«бТѕиуџёТЪЦУ»бтЙђтЙђТ»ћУЙЃтцЇТЮѓтцџТаи№╝їJoinу╗ЈтИИС╝џТХЅтЈіСИЇтљїУіѓуѓ╣С╣ІжЌ┤уџёТЋ░ТЇ«С║цТЇб№╝їJoinуџёСИцСИфУАеуџёJoinжћ«СИЇСИђт«џТў»СИђСИфУАеуџётѕєтИЃжћ«№╝їУ┐ЎуДЇТЃЁтєхСИІт░▒С╝џТХЅтЈітѕ░ТЋ░ТЇ«уџёжЄЇтѕєтИЃсђѓтюеTDSQL-AСИГ№╝їТЋ░ТЇ«жЄЇтѕєтИЃТў»ућ▒Remote Subplanу«ЌтГљТЮЦТЅДУАїсђѓтюеТЅДУАїуџёТЌХтђЎ№╝їRemote Subplanу«ЌтГљС╝џт╣ХУАїтю░тѕЏт╗║т»╣т║ћСИІт▒ѓуџёТЅДУАїУ┐ЏуеІтњїт»╣т║ћуџёDNУ┐ъТјЦ№╝їТ»ЈСИфDNжЃйС╝џтѕЏт╗║т»╣т║ћтЁХС╗ќDNуџётљёСИфжЊЙТјЦ№╝їУ┐Ўт░▒С╝џт»╝УЄ┤жЊЙТјЦТЋ░тњїУ┐ЏуеІТЋ░ТђЦтЅДУєеУЃђ№╝їу╗ЎТюЇтіАтЎежђаТѕљтЙѕтцДуџётјІтіЏсђѓ

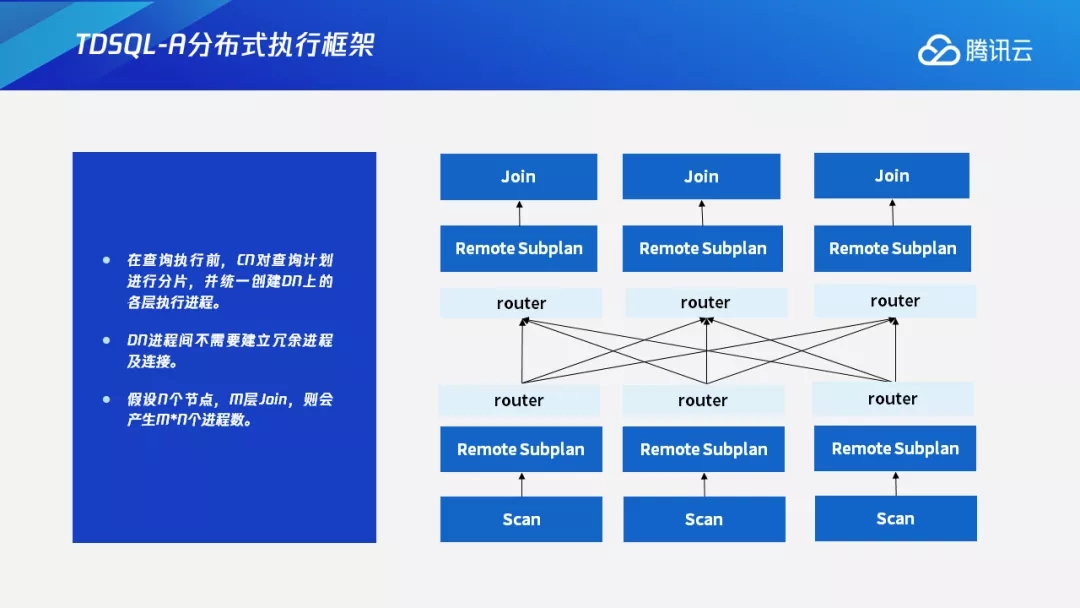

1.3 TDSQL-AтѕєтИЃт╝ЈТЅДУАїТАєТъХ

жњѕт»╣тјЪтѕєтИЃт╝ЈТъХТъёуџёу╝║уѓ╣№╝їТѕЉС╗гУ«ЙУ«АС║єСИђтЦЌтЁеТќ░уџётѕєтИЃт╝ЈТЅДУАїТАєТъХсђѓтюеУ┐ЎуДЇТЅДУАїТАєТъХСИІ№╝їТЪЦУ»бТЅДУАїтЅЇCNС╝џт»╣ТЪЦУ»бУ«АтѕњУ┐ЏУАїтѕєуЅЄ№╝їт╣ХтѕЏт╗║DNСИіуџётљёСИфТЅДУАїУ┐ЏуеІ№╝їТ»ЈСИфDNуџёУ┐ЏуеІжЌ┤СИЇжюђУдЂтєЇт╗║уФІтєЌСйЎуџёУ┐ЏуеІтЈіУ┐ъТјЦсђѓУ┐ЎтЈ»С╗ЦтЄЈт░ЉСИЇт┐ЁУдЂуџёУ┐ЏуеІтњїУ┐ъТјЦ№╝їтЄЈУй╗ТюЇтіАтЎеуџёУ┤ЪТІЁ№╝їт╣ХСИћУЃйтцЪтЂџтѕ░Т»ћУЙЃтЦйуџёу║┐ТђДТЅЕт▒ЋТђДсђѓТЋ░ТЇ«С║цС║њтѕЎТў»жђџУ┐ЄСИГжЌ┤уџёrouterРђћРђћFNУіѓуѓ╣ТЮЦУ┐ЏУАїТЋ░ТЇ«С║цТЇб№╝їУ┐ЎТў»тйЊтЅЇTDSQL-AуџётѕєтИЃт╝ЈТЅДУАїТАєТъХсђѓ

С║їсђЂТЪЦУ»бУ«АтѕњтѕєуЅЄуГќуЋЦ

2.1 ТЪЦУ»бУ«АтѕњтѕєуЅЄУ┐ЄуеІ

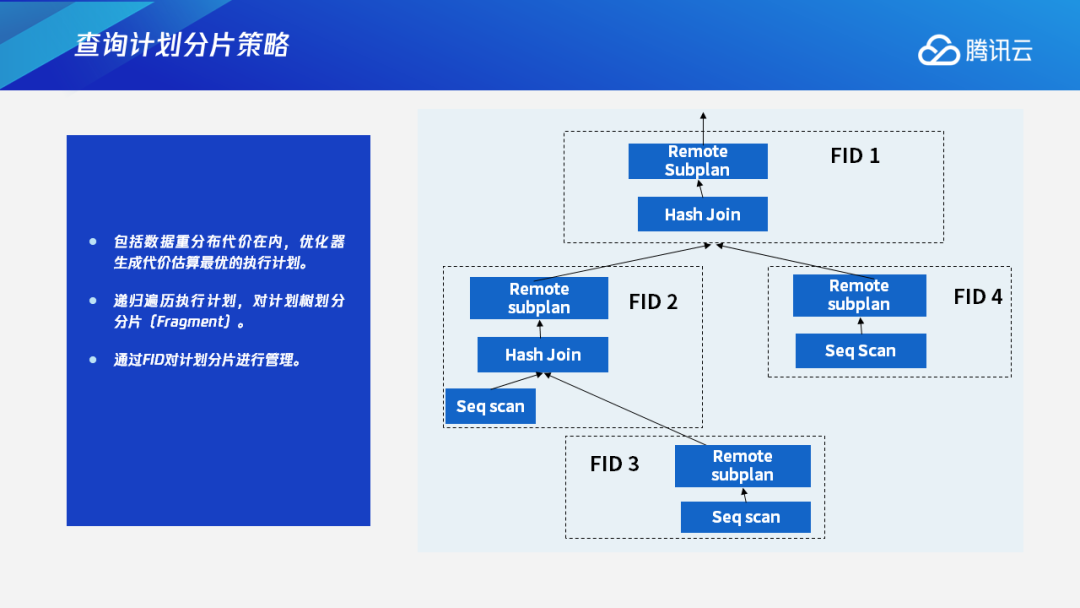

С╣ІТЅђС╗ЦУдЂт»╣ТЪЦУ»бУ«АтѕњУ┐ЏУАїтѕєуЅЄ№╝їСИ╗УдЂТў»тЏаСИ║СИђСИфтѕєтИЃт╝ЈуџёТЪЦУ»бУ«Атѕњ№╝їтюеу╗ЮтцДтцџТЋ░ТЃЁтєхСИІ№╝їт┐ЁуёХС╝џтїЁтљФТЋ░ТЇ«уџёжЄЇтѕєтИЃсђѓтюеТѕЉС╗гуџёТЅДУАїТАєТъХСИГ№╝їТа╣ТЇ«ТЋ░ТЇ«жЄЇтѕєтИЃУ┐ЏУАїТЪЦУ»бУ«Атѕњуџётѕњтѕєсђѓ

ждќтЁѕтїЁТІгТЋ░ТЇ«жЄЇтѕєтИЃуџёС╗БС╗итюетєЁ№╝їС╝ўтїќтЎеС╝џућЪТѕљСИђСИфС╗БС╗иС╝░у«ЌТюђС╝ўуџёТЅДУАїУ«АтѕњсђѓтюеУ┐ЎСИфТЅДУАїУ«АтѕњСИі№╝їТѕЉС╗гС╝џтЂџУ«АтѕњТаЉуџётѕњтѕєтѕєуЅЄРђћРђћТііТ»ЈСИђСИфТЋ░ТЇ«жЄЇтѕєтИЃуџёУіѓуѓ╣СИІжЮбуџётГљТЋ░СйюСИ║СИђСИфУ«АтѕњуџётѕєуЅЄ№╝їтєЇжђџУ┐ЄFIDТЮЦт»╣Т»ЈСИђСИфУ«АтѕњтѕєуЅЄУ┐ЏУАїу«Ауљєсђѓ

С╗ЦСИІтЏЙСИ║СЙІ№╝їтЂЄУ«ЙТюЅСИђСИфСИцт▒ѓуџёHash Join№╝їТ»ЈСИђт▒ѓТХЅтЈітѕ░СИђС║Џт»╣т║ћуџёТЋ░ТЇ«жЄЇтѕєтИЃ№╝їт░▒С╝џТюЅСИђСИфтЏЏтѕєуЅЄуџёТЪЦУ»буџёС║ДућЪсђѓ

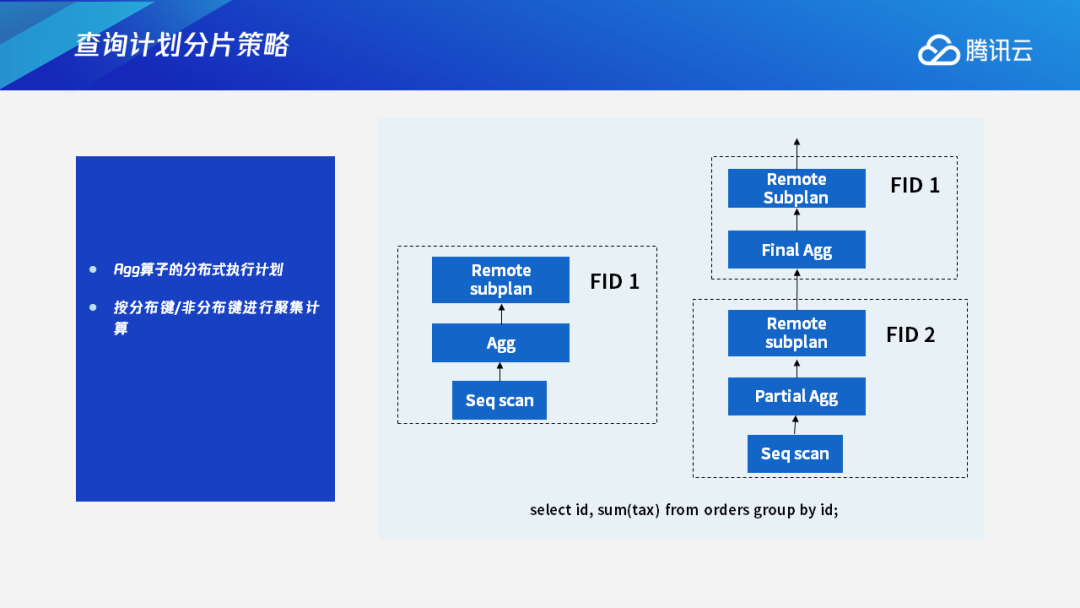

2.2 Aggу«ЌтГљТЅДУАїУ«Атѕњ

тюетѕєтИЃт╝ЈТЋ░ТЇ«т║ЊжЄїжЮб№╝їт»╣тЁХС╗ќуџёу«ЌтГљ№╝їС╣ЪС╝џућЪТѕљСИђСИфтѕєтИЃт╝ЈуџёТЅДУАїУ«Атѕњ№╝їТ»ћтдѓOLAPтю║ТЎ»жЄїжЮбу╗ЈтИИСй┐ућеуџёТЅДУАїУЂџтљѕУ«Ау«ЌуџёAggу«ЌтГљсђѓтюеУЂџтљѕУ«Ау«ЌСИГ№╝їТ»ћтдѓgroup idТГБтЦйТў»УАеуџётѕєтИЃжћ«уџёТЃЁтєхСИІ№╝їтЈ»С╗ЦућЪТѕљтЇЋуІгуџётѕєуЅЄ№╝їт░▒тЃЈСИІтЏЙСИГFID 1У┐ЎТаиуџётѕєуЅЄсђѓТ»ЈСИфAggТЊЇСйюжЃйТў»тюеDNТюгтю░ТЅДУАї№╝їТюђтљјТ▒ЄТђ╗тѕ░CNСИітЙЌтѕ░СИђСИфТюђу╗ѕу╗ЊТъюсђѓСйєТў»тюеТюЅС║ЏТЃЁтєхСИІ№╝їТ»ћтдѓУЂџтљѕжћ«СИЇТў»тѕєтИЃжћ«уџёТЃЁтєхСИІ№╝їт░▒С╝џтюеТюђСИІт▒ѓуџёУіѓуѓ╣СИітЂџжЃетѕєуџёУЂџтљѕТЊЇСйю№╝їтюеСИіт▒ѓуџёУіѓуѓ╣у╗ЈУ┐ЄТЋ░ТЇ«жЄЇтѕєтИЃС╣ІтљјтєЇтЂџТюђтљјуџёУЂџтљѕТЊЇСйю№╝їтЙЌтѕ░Тюђу╗ѕу╗ЊТъюсђѓУ┐Ўт░▒Тў»СИђСИфтѕєтИЃт╝ЈуџёAggу«ЌтГљуџёТЅДУАїУ«Атѕњсђѓ

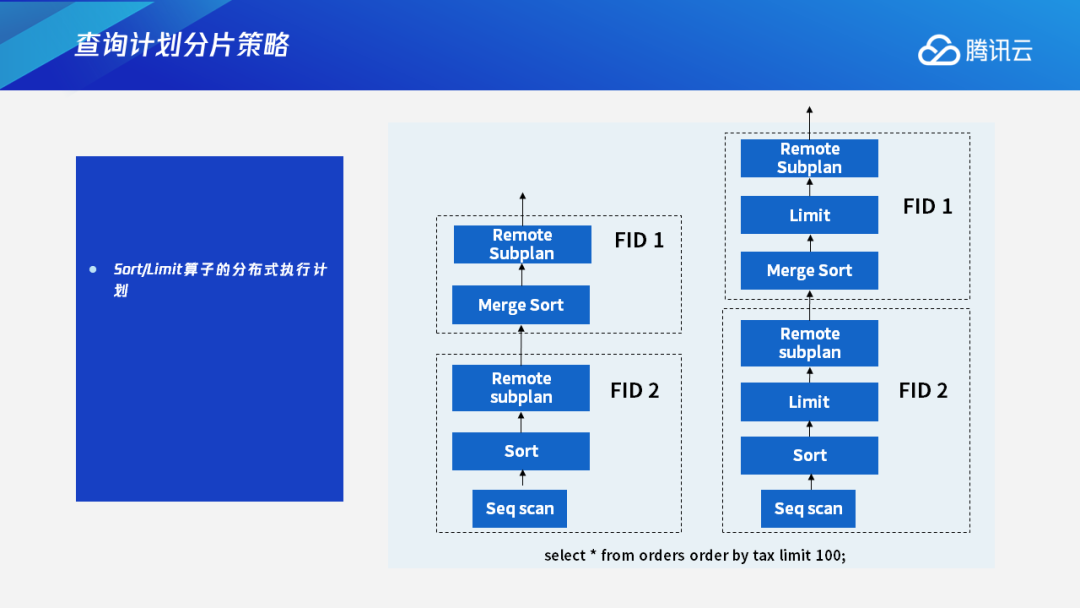

2.3 Sortу«ЌтГљ&Limitу«ЌтГљТЅДУАїУ«Атѕњ

Sortу«ЌтГљУ┐ўТюЅLimitу«ЌтГљС╣ЪТў»тљїТаиуџёжђ╗УЙЉсђѓ

т»╣С║јSortу«ЌтГљ№╝їТѕЉС╗гС╝џтюеDNТюгтю░тЁѕтЂџСИђТгАТјњт║Ј№╝їу╗ЈУ┐ЄТЋ░ТЇ«жЄЇтѕєтИЃтљј№╝їтюеСИіт▒ѓУіѓуѓ╣тєЇУ┐ЏУАїтйњт╣Х№╝їТюђтљјтЙЌтѕ░Тюђу╗ѕуџёТјњт║Ју╗ЊТъюсђѓ

т»╣С║јLimitу«ЌтГљ№╝їТѕЉС╗гС╝џТііт«ЃУ┐ЏУАїСИІТјесђѓТ»ћтдѓУ»┤СИІжЮбУ┐ЎСИфСЙІтГљСИГ№╝їУ┐ЎТЮАТљюу┤бУ»ГтЈЦТў»ТЪЦУ»бтЅЇ100тљЇуџёtest order№╝їУ┐ЎТаиуџёУ»ЮТѕЉС╗гС╝џТііLimitу«ЌтГљУ┐ЏУАїСИІТје№╝їТ»ЈСИфDNтЈфУ┐ћтЏъLimit 100ТЮАТЋ░ТЇ«у╗ЎСИіт▒ѓУіѓуѓ╣№╝їСИіт▒ѓУіѓуѓ╣тюеТћХтѕ░у╗ЊТъюС╣ІтљјтєЇУ┐ЏУАїтљѕт╣ХТјњт║Ј№╝їТюђтљјтЈќLimit 100уџёу╗ЊТъюСйюСИ║Тюђу╗ѕу╗ЊТъюУ┐ћтЏъу╗ЎСИіт▒ѓсђѓ

СИЅсђЂт╝ѓТГЦТЅДУАїТхЂуеІТјДтѕХ

3.1 т╝ѓТГЦТЅДУАїтЁиСйЊТхЂуеІ

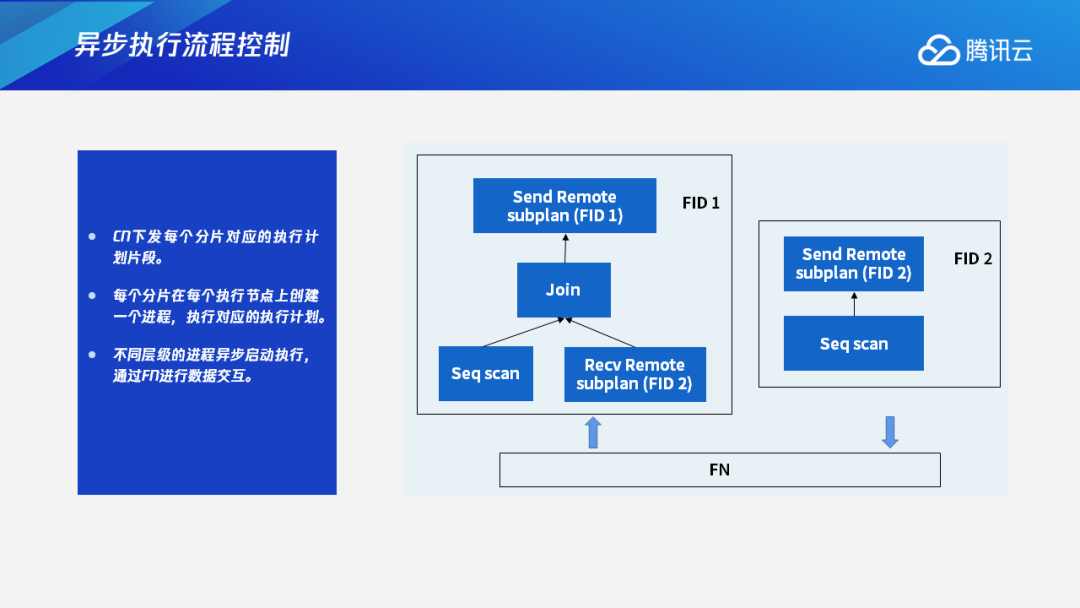

тюеућЪТѕљТЪЦУ»бУ«АтѕњуџётѕєуЅЄтљј№╝їCNС╝џСИІтЈЉТ»ЈСИфтѕєуЅЄт»╣т║ћуџёТЅДУАїУ«АтѕњуЅЄТ«х№╝їтѕєтѕФтЈЉжђЂу╗ЎтљёСИфDN№╝їуёХтљјТ»ЈСИфтѕєуЅЄтюеТ»ЈСИфТЅДУАїУіѓуѓ╣СИіС╝џтѕЏт╗║СИђСИфУ┐ЏуеІ№╝їТЅДУАїт»╣т║ћуџёТЅДУАїУ«АтѕњсђѓСИЇтљїт▒ѓу║ДуџёУ┐ЏуеІт╝ѓТГЦтљ»тіеТЅДУАї№╝їжђџУ┐ЄFNУ┐ЏУАїТЋ░ТЇ«С║цС║њсђѓ

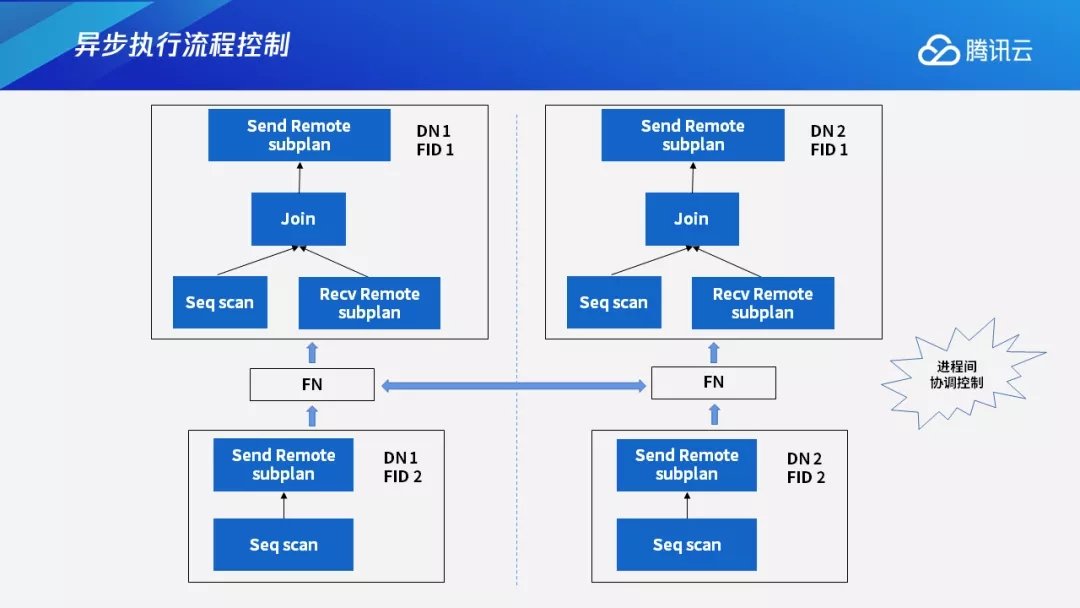

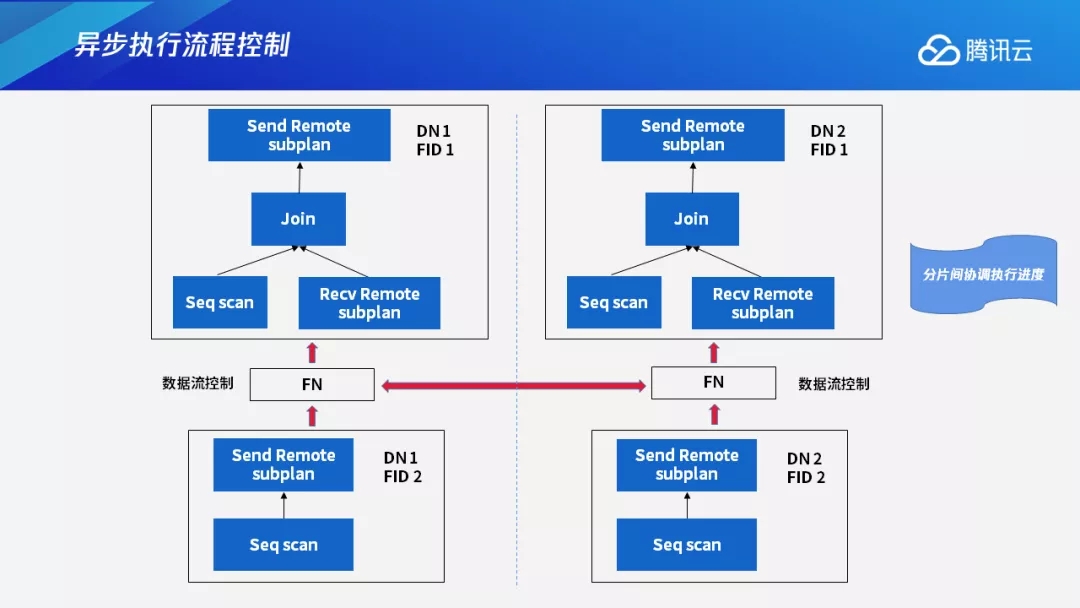

СИІтЏЙСИГтЈ»С╗ЦуюІтѕ░№╝їУ┐ЎжЄїТюЅСИцСИфТЪЦУ»б№╝їтѕєтѕФТў»у«ђтЇЋуџёJoinТЪЦУ»б№╝їС╗ЦтЈіТЋ░ТЇ«жЄЇтѕєтИЃуџёJoinТЪЦУ»бсђѓтдѓТъюТў»С╝ау╗ЪуџёТЋ░ТЇ«т║ЊТЅДУАїТхЂуеІ№╝їт░▒С╝џтЁѕтљ»тіеСИІт▒ѓУіѓуѓ╣№╝їтєЇтљ»тіеСИіт▒ѓУіѓуѓ╣сђѓСйєтюеТѕЉС╗гУ«ЙУ«АуџёУ┐ЎуДЇТЅДУАїТАєТъХСИІ№╝їFID 1тњїFID 2Тў»тљїТГЦтљ»тіеуџё№╝їт«ЃС╗гС╣ІжЌ┤жђџУ┐ЄFNТЮЦУ┐ЏУАїТЋ░ТЇ«С║цС║њсђѓ

тдѓТъютюеТюЅСИцСИфТЋ░ТЇ«Уіѓуѓ╣уџёТЃЁтєхСИІ№╝їJoinТЪЦУ»бТђјС╣ѕтљ»тіеТЅДУАїУ┐ЏуеІтЉб№╝ЪтЏаСИ║ТюЅСИцСИфтѕєуЅЄ№╝їУ┐ўТюЅСИцСИфТЋ░ТЇ«Уіѓуѓ╣№╝їТЅђС╗ЦтюеТЅДУАїуџёУ┐ЄуеІСИГ№╝їТюЅтЏЏСИфУ┐ЏуеІтюетљїТЌХТЅДУАїсђѓ

ТюђСИІжЮбуџёУ┐ЎСИцСИфтѕєуЅЄ№╝їжЃйт▒ъС║јFID 2№╝їСйєтѕєтѕФтюеDN 1тњїDN 2СИіТЅДУАї№╝їТЅДУАїт»╣т║ћуџёУ«АтѕњтѕєуЅЄсђѓт»╣тЁХСИГСИђСИфУАеУ┐ЏУАїТЅФТЈЈ№╝їтєЇжђџУ┐ЄFNУіѓуѓ╣У┐ЏУАїТЋ░ТЇ«С║цТЇбсђѓСИіжЮбуџёУ┐ЎСИцСИфтѕєуЅЄжЃйт▒ъС║јFID 1№╝їтѕєтѕФтюеDN 1тњїDN 2СИіТЅДУАї№╝їт«ЃС╗гтѕєтѕФУјитЈќУЄфти▒ТЅђжюђУдЂуџёТЋ░ТЇ«№╝їтљїТЌХТЅДУАїУЄфти▒уџёТЅДУАїУ«АтѕњтѕєуЅЄсђѓТюђу╗ѕ№╝їСИцСИфFID 1уџёТЅДУАїУ┐ЏуеІС╝џТііТюђу╗ѕу╗ЊТъютЈЉжђЂу╗ЎCNсђѓУ┐ЎтЏЏСИфУ┐ЏуеІТў»тљїТГЦТЅДУАїуџё№╝їтюеТЋ░ТЇ«С║цТЇбуџёТЌХтђЎжђџУ┐ЄFNТЮЦУ┐ЏУАїсђѓ

3.2 УЄфжђѓт║ћТхЂуеІТјДтѕХ

TDSQL-AТЅДУАїТАєТъХТюђтцДуџёжџЙуѓ╣т░▒тюеС║јУ┐ЏуеІжЌ┤тдѓСйЋУ┐ЏУАїтЇЈУ░ЃтњїТјДтѕХсђѓжњѕт»╣У┐ЎСИфжЌ«жбў№╝їТѕЉС╗гУ«ЙУ«АС║єСИђСИфтЁиТюЅУЄфжђѓт║ћуЅ╣уѓ╣уџёт╝ѓТГЦТЅДУАїуџёТхЂуеІТјДтѕХТю║тѕХсђѓт«ЃСИ╗УдЂТюЅС╗ЦСИІСИЅСИфТќ╣жЮбуџёуЅ╣уѓ╣№╝џ

┬иуЂхТ┤╗ТјДтѕХТЅДУАїУ┐Џт║дсђѓТа╣ТЇ«т«ъжЎЁТЅДУАїТЃЁтєх№╝їDNтіеТђЂтю░ТјДтѕХтљёСИфУ┐ЏуеІС╣ІжЌ┤уџёТЅДУАїУ┐Џт║дсђѓ

┬иТа╣ТЇ«тЅЇуФ»У«Йуй«ТїЅжюђТЅДУАї№╝їС╝ўтїќУхёТ║љтѕЕуће№╝їт┐ФжђЪтЊЇт║ћт╝ѓтИИсђѓТ»ћтдѓтЅЇуФ»тЈЉжђЂCancelУ»иТ▒ѓТЌХ№╝їУЃйтцЪтЈіТЌХтЊЇт║ћтцёуљєсђѓтдѓТъюС╗╗СйЋТЅДУАїУ┐ЏуеІтЈЉућЪт╝ѓтИИ№╝їС╣ЪУЃйтцЪт┐ФжђЪтЊЇт║ћтцёуљєсђѓ

┬иС┐ЮУ»ЂтѕєтИЃт╝ЈС║ІтіАСИђУЄ┤ТђДсђѓТХЅтЈіС┐«Тћ╣ТЊЇСйюуџётѕєуЅЄС╝џт╝ђтљ»С║ІтіА№╝їт╣ХСИћтљїТГЦТЅДУАїУ┐ЎСИфС║ІтіАуџёТЈљС║цТѕќУђЁтЏъТ╗џуГЅТЊЇСйюсђѓ

СИІжЮбТѕЉт░єтѕєтѕФС╗јУ┐ЎСИЅСИфТќ╣жЮбТЮЦС╗Іу╗ЇСИђСИІУ┐ЎСИфт╝ѓТГЦТЅДУАїТхЂуеІТјДтѕХТю║тѕХсђѓ

тюетљёСИфУ┐ЏуеІтљїТГЦТЅДУАїуџёТЃЁтєхСИІ№╝їтдѓТъюТюЅуџёУ┐ЏуеІтЄ║уј░ТЅДУАїжў╗тАъуџёТЃЁтєх№╝їУ»ЦТђјТаиС║њуЏИтЇЈУ░ЃтЉб№╝Ъ

С╗ЦСИІтЏЙСИ║СЙІ№╝їтЂЄУ«ЙСИіт▒ѓУіѓуѓ╣СИГуџёFID 1уџёУ┐ЎСИцСИфТЅДУАїУ┐ЏуеІТЅДУАїТ»ћУЙЃТЁб№╝їУђїСИІт▒ѓFID 2уџёУ┐ЎСИцСИфУ┐ЏуеІТЅДУАїУ┐Џт║дТ»ћУЙЃт┐ФуџёТЌХтђЎ№╝їСИІт▒ѓFID 2уџёСИцСИфУ┐ЏуеІС╝џТ║љТ║љСИЇТќГтю░тљЉСИіт▒ѓтЈЉжђЂт«ЃС╗гуџёТЅДУАїу╗ЊТъюсђѓтдѓТъюСИЇтіаТјДтѕХуџёУ»Ю№╝їСИЇС╗ЁС╝џТхфУ┤╣СИІт▒ѓFID 2уџёТЅДУАїУхёТ║љ№╝їУђїСИћС╝џжђаТѕљуйЉу╗юуџёжў╗тАъсђѓ

жњѕт»╣У┐ЎуДЇТЃЁтєх№╝їТѕЉС╗гУ«ЙУ«АС║єУ┐ЏуеІжЌ┤тЈ»С╗ЦС║њуЏИтЇЈУ░ЃТЅДУАїУ┐Џт║дуџёТјДтѕХТю║тѕХ№╝їСИ╗УдЂжђџУ┐ЄТЋ░ТЇ«ТхЂТјДтѕХТЮЦт«ъуј░сђѓтдѓТъюСИіт▒ѓУіѓуѓ╣уџёТЅДУАїУ┐Џт║дТЁбС║јжбёТюЪуџёТЌХтђЎ№╝їСИІт▒ѓУіѓуѓ╣С╝џУ┐ЏУАїуГЅтЙЁ№╝їуГЅтѕ░СИіт▒ѓУіѓуѓ╣УЃйтцЪу╗Ду╗ГТЅДУАїТЌХ№╝їСИІт▒ѓУіѓуѓ╣ТЅЇС╝џу╗Ду╗ГтЂџУЄфти▒У«АтѕњтѕєуЅЄуџёТЅДУАї№╝їТііТЋ░ТЇ«тЈЉжђЂу╗ЎСИіт▒ѓУіѓуѓ╣сђѓУ┐ЎТаитЈ»С╗ЦтюеТЅДУАїУіѓуѓ╣СИіУЙЙтѕ░УхёТ║љтѕєжЁЇтњїСй┐ућеУЙЃС╝ўуџёТЋѕТъю№╝їуЕ║тЄ║ТЮЦуџёуйЉу╗юУхёТ║љтњїCPU/IOУхёТ║љт░▒тЈ»С╗ЦУ«ЕТИАу╗ЎтЁХС╗ќТЪЦУ»бТЮЦТЅДУАїсђѓ

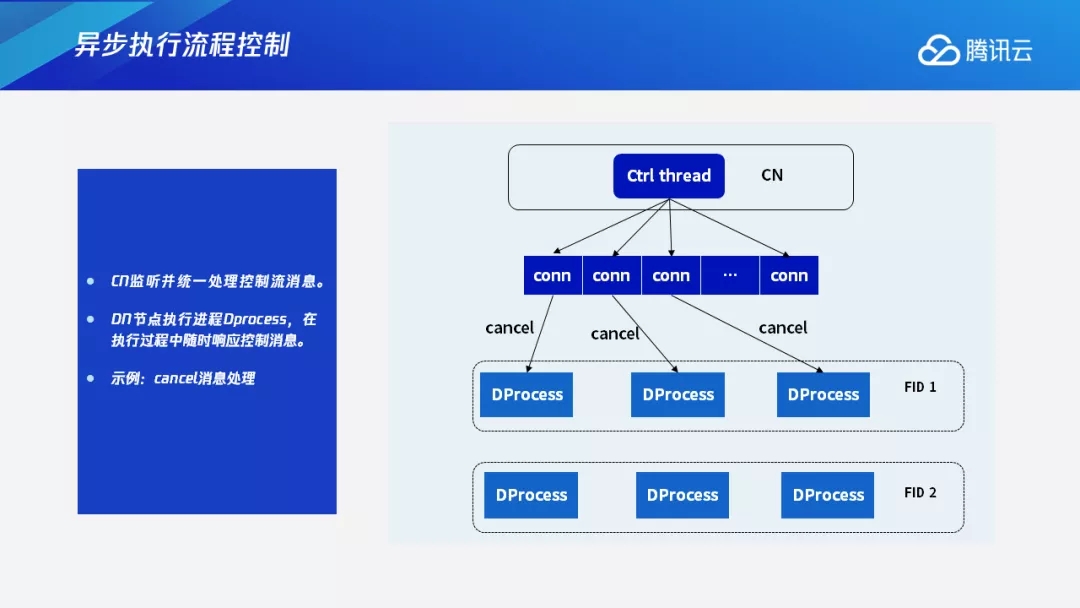

ТѕЉС╗гуџёТјДтѕХТю║тѕХСИГжЎцС║єТЋ░ТЇ«ТхЂС╣Ітцќ№╝їУ┐ўТюЅТјДтѕХТхЂсђѓућ▒CNТЮЦуЏЉтљгт╣Ху╗ЪСИђтцёуљєТјДтѕХТхЂТХѕТЂ»сђѓDNУіѓуѓ╣уџёТЅДУАїУ┐ЏуеІ№╝їтЈѕтЈФDprocess№╝їтюеТЅДУАїуџёУ┐ЄуеІСИГС╝џжџЈТЌХтЊЇт║ћТјДтѕХТХѕТЂ»сђѓС╗ЦСИІтЏЙСИ║СЙІ№╝їтдѓТъюућеТѕиТЅДУАїСИђСИфТ»ћУЙЃжЋ┐уџёУ┐ЏуеІТѕќУђЁУ»»ТЅДУАїС║єСИђСИфQuery№╝їтюеТЅДУАїтЄатѕєжњЪтљј№╝їСИЇТЃ│тєЇТЅДУАїС║є№╝їт░▒С╝џу╗ЎCNтЈЉжђЂСИђСИфCancelС┐АтЈитЈќТХѕТЪЦУ»б№╝їУ┐ЎТЌХCNС╝џТііУ┐ЎСИфС┐АтЈижђџУ┐ЄжЊЙТјЦтЈЉжђЂу╗ЎТ»ЈСИфТЅДУАїУ┐ЏуеІ№╝їDNСИіуџёТЅДУАїУ┐ЏуеІТћХтѕ░С┐АтЈитљјт░▒С╝џу╗ѕТГбТЅДУАї№╝їтЈіТЌХТііУхёТ║љУ«ЕТИАтЄ║ТЮЦу╗ЎтЁХС╗ќуџёТЪЦУ»бСй┐ућесђѓУ┐ЎТў»CancelТХѕТЂ»уџётцёуљєУ┐ЄуеІсђѓ

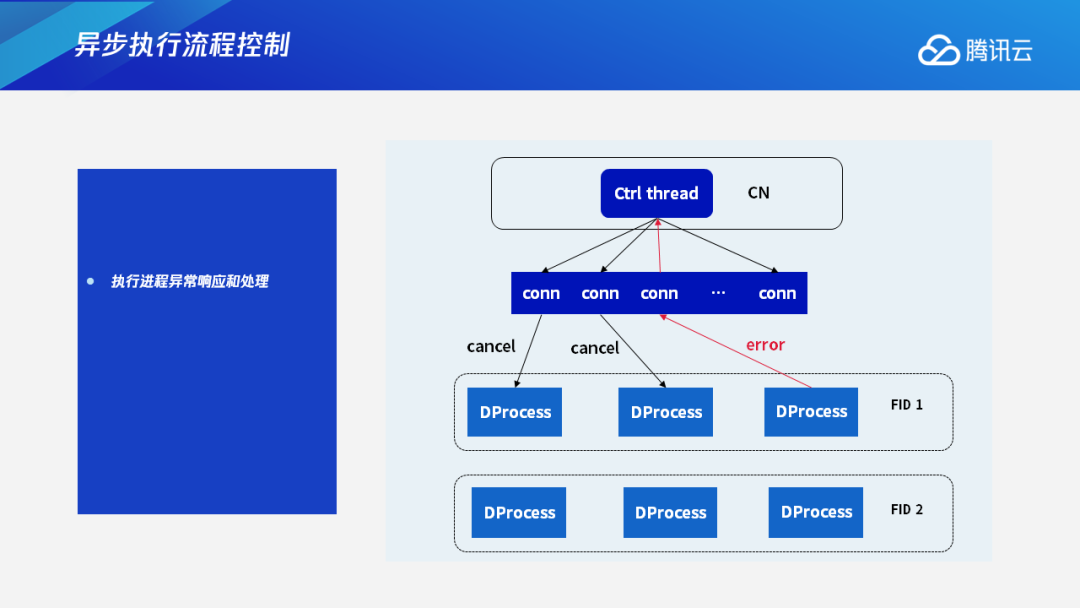

жЎцС║єCancelТХѕТЂ»тцќ№╝їТѕЉС╗гУ┐ўтцёуљєErrorС┐АТЂ»сђѓтюеТЅДУАїУ┐ЏуеІтљїТГЦТЅДУАїуџёУ┐ЄуеІСИГ№╝їТ»ЈСИфТЅДУАїУ┐ЏуеІС╣ІжЌ┤жђџУ┐ЄFNТЮЦУ┐ЏУАїТЋ░ТЇ«С║цТЇбсђѓтдѓТъютЁХСИГСИђСИфУ┐ЏуеІтЈЉућЪError№╝їТ»ћтдѓтюетцёуљєуџёУ┐ЄуеІСИГУхёТ║љСИЇУХ│№╝їТѕќУђЁтюетцёуљєУ┐ЄуеІСИГжЂЄтѕ░ТЋ░ТЇ«жћЎУ»»ТѕќтЁХС╗ќжћЎУ»»уГЅ№╝їУ┐ЎТЌХт«ЃС╝џТіЦErrorС┐АтЈи№╝їжђџУ┐ЄжЊЙТјЦт░єУ┐ЎСИфС┐АтЈиСИіТіЦу╗ЎCNсђѓCNтюеТћХтѕ░ТЅДУАїУ┐ЏуеІErrorТХѕТЂ»тљј№╝їС╝џУ┐ЏУАїТХѕТЂ»тцёуљє№╝їуёХтљјСИІтЈЉу╗ЎтЁХС╗ќуџёТЅДУАїУ┐ЏуеІ№╝їУ«Ет«ЃС╗гу╗ѕТГбТЅДУАїсђѓС╣Ът░▒Тў»У»┤№╝їтдѓТъюС╗╗СйЋСИђСИфт╣ХУАїТЅДУАїуџёУ┐ЏуеІтЈЉућЪС║єжћЎУ»»№╝їТѕЉС╗гС╣ЪУЃйтцЪтЈіТЌХтЈќТХѕсђЂу╗ЊТЮЪУ┐ЎСИфТЪЦУ»бсђѓ

3.3 ТЅДУАїТхЂуеІуц║СЙІ

СИІтЏЙТў»СИђСИфТђ╗СйЊТЅДУАїТхЂуеІуџёуц║СЙІсђѓтидСЙДТў»СИђСИфтИдТюЅТЋ░ТЇ«жЄЇтѕєтИЃуџёJoinТЪЦУ»б№╝їт«ЃуџёТЋ┤СйЊТЅДУАїТхЂуеІтЈ»С╗ЦућетЈ│УЙ╣уџёУ┐ЎСИфтЏЙТЮЦУАеуц║сђѓтЏЏСИфТЅДУАїУ┐ЏуеІС╣ІжЌ┤С╝џТюЅТЋ░ТЇ«С║цТЇб№╝їТў»жђџУ┐ЄFNТЮЦС║цТЇбТЋ░ТЇ«ТхЂ№╝їТюђу╗ѕу╗ЊТъюС╣ЪТў»жђџУ┐ЄFNТЋ░ТЇ«ТхЂУ┐ћУ┐ўу╗ЎCN№╝їCNСИіУ┐ўТюЅСИђСИфтљјтЈ░у║┐уеІ№╝їжђџУ┐ЄТјДтѕХТхЂТјДтѕХтљёСИфТЅДУАїУ┐ЏуеІС╣ІжЌ┤уџёТЅДУАї№╝їУ┐Ўт░▒Тў»ТЋ┤СйЊуџёТЅДУАїТъёТъХсђѓ

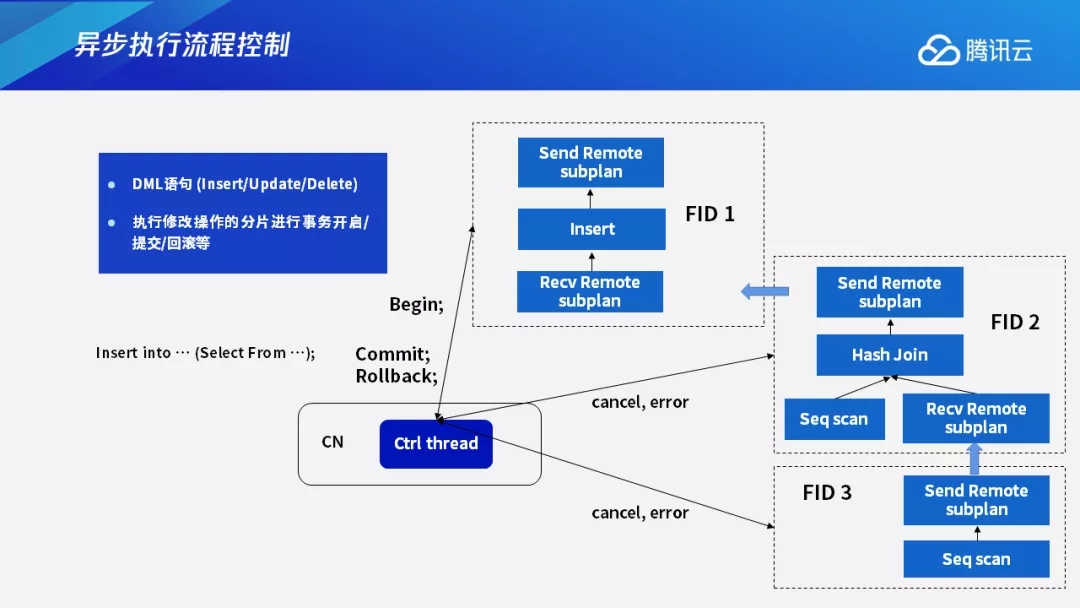

жЎцС║єТЪЦУ»бУ»ГтЈЦтцќ№╝їТѕЉС╗гУ┐ўС╝џжЂЄтѕ░DMLУ»ГтЈЦсђѓDMLУ»ГтЈЦтЇ│InsertсђЂUpdateсђЂDeleteУ»ГтЈЦ№╝їт«ЃС╗гжюђУдЂУ┐ЏУАїтѕєтИЃт╝ЈТЅДУАїС║ІтіАуџёТЈљС║цТѕќУђЁтЏъТ╗џТЊЇСйюсђѓтюеТЅДУАїУ┐ЄуеІСИГ№╝їТѕЉС╗гСИ╗УдЂТў»ТііС┐«Тћ╣ТЊЇСйюжЏєСИГтюеСИђСИфтѕєуЅЄтєЁ№╝їуёХтљјтюеТЅДУАїС┐«Тћ╣ТЊЇСйюуџёУ┐ЎСИфтѕєуЅЄтєЁУ┐ЏУАїС║ІтіАуџёт╝ђтљ»сђЂТЈљС║цтњїтЏъТ╗џуГЅТЊЇСйюсђѓУ┐ЎСИфС║ІтіАуџётЉйС╗цтљїТаиС╣ЪТў»жђџУ┐ЄТјДтѕХу║┐уеІТЮЦУ┐ЏУАїтЈЉжђЂ№╝їтЁХС╗ќу║┐уеІС╣ЪтљїТаиТў»жђџУ┐ЄCancelТѕќУђЁСИіТіЦErrorТЮЦтцёуљєТјДтѕХТХѕТЂ»сђѓ

У┐ЎжЄїСИЙСИђСИфТюђтЁИтъІуџёСЙІтГљсђѓТЅДУАїInsert intoУ»ГтЈЦТЌХ№╝їтдѓТъютљјжЮбУиЪуџёТў»Select From№╝їС╣Ът░▒Тў»тюетЁХС╗ќуџёУАеСИГу╗ЈУ┐ЄТЪЦУ»бТЊЇСйюУјитЙЌСИђСИфу╗ЊТъюжЏє№╝їТііУ┐ЎСИфу╗ЊТъюжЏєТЈњтЁЦтѕ░СИђСИфУАеСИГ№╝їТГцТЌХТѕЉС╗гтюетЁХС╗ќтѕєуЅЄСИіТЅДУАїтЈфУ»╗ТЊЇСйю№╝їтЈфтюеуггСИђСИфтїЁтљФInsertуџётѕєуЅЄСИіТЅДУАїС┐«Тћ╣ТЊЇСйю№╝їУ┐ЎСИфС┐«Тћ╣ТЊЇСйют░▒ТХЅтЈіС║ІтіАуџёТЈљС║цтњїтЏъТ╗џсђѓ

3.4 СИГТГбтцёуљєТхЂуеІ

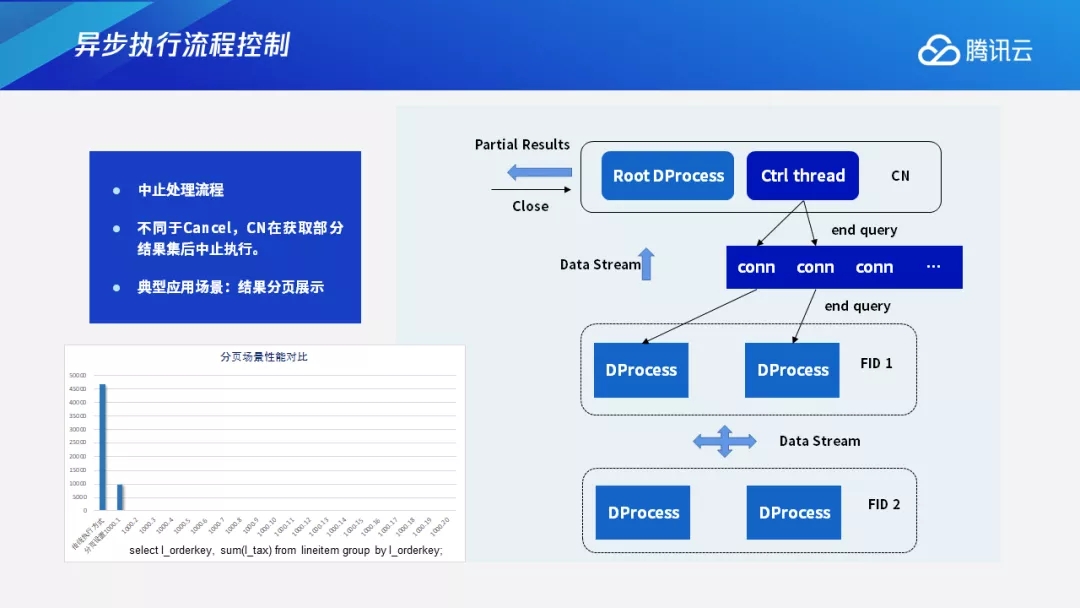

У┐ЎжЄїжЄЇуѓ╣С╗Іу╗ЇСИГТГбтцёуљєТхЂуеІ№╝їт«ЃтњїCancelТхЂуеІСИЇСИђТаисђѓСИГТГбтцёуљєТхЂуеІТў»CNтюеУјитЈќС║єжЃетѕєуџёТЪЦУ»бу╗ЊТъюжЏєтљјСИГТГбТЅДУАїсђѓтЁИтъІуџёт║ћућетю║ТЎ»Тў»ТііТЪЦУ»бу╗ЊТъютЂџтѕєжАхт▒Ћуц║сђѓтюетЙѕтцџтЅЇуФ»уџёт║ћућеСИГ№╝їТЪЦУ»бу╗ЊТъют░▒Тў»ућетѕєжАхт▒Ћуц║уџётйбт╝Јт▒Ћуј░тюет«бТѕиуФ»жАхжЮбСИіуџёсђѓ

Т»ћтдѓСИђСИфТЪЦУ»б№╝їуггСИђжАхтЈ»УЃйТюЅ1000ТЮАТЪЦУ»бу╗ЊТъю№╝їСИІСИђжАхтѕЎТў»СИІ1000ТЮАТЪЦУ»бу╗ЊТъюсђѓCNтюеТЪЦУ»бТЅДУАїуџёТЌХтђЎ№╝їтЈфУдЂТЅДУАїУјитЈќтѕ░1000ТЮАу╗ЊТъю№╝їт░▒тЈ»С╗ЦУ┐ћтЏъу╗ЎтЅЇуФ»№╝їУ«ЕтЅЇуФ»тЂџт▒Ћуц║ТѕќУђЁтцёуљєсђѓтЏаСИ║тЅЇуФ»уеІт║ЈтцёуљєТЪЦУ»бу╗ЊТъюС╣ЪжюђУдЂТЌХжЌ┤№╝їтюеУ┐ЎТЌХ№╝їтљјуФ»т░▒тЈ»С╗Цу╗Ду╗ГТЅДУАїУјитЈќСИІ1000ТЮАТЪЦУ»бу╗ЊТъю№╝їУ┐ЎТаит░▒УЃйт«ъуј░тЅЇуФ»тњїтљјуФ»т╣ХУАїТЅДУАї№╝їтЈќтЙЌТЅДУАїТЋѕујЄТЋ┤СйЊТюђС╝ўтїќсђѓ

тюеУ┐ЎуДЇТЅДУАїТхЂуеІСИІ№╝їCNС╝џтЁѕУјитЈќтЅЇ1000ТЮАу╗ЊТъюРђћРђћУ»ЦТЋ░тђ╝ућеТѕитЈ»С╗ЦУЄфућ▒У«Йуй«№╝їтюеУјитЈќтѕ░ТїЄт«џу╗ЊТъюжЏєС╣ІтљјCNтЁѕУ┐ћтЏъу╗ЎтЅЇуФ»№╝їтЅЇуФ»тцёуљєт«їС╣Ітљј№╝їтдѓТъюжюђУдЂтєЇУјитЈќ№╝їCNт░▒С╝џу╗Ду╗ГУ┐ћтЏъСИІСИђТЅ╣у╗ЊТъюсђѓ

тдѓТъютЅЇуФ»ТЪЦУ»бтЈќТХѕ№╝їТ»ћтдѓућеТѕитЈ»УЃйуюІ5жАхТѕќУђЁ6жАхС╣ІтљјСИЇТЃ│тєЇуюІ№╝їТѕќУђЁТў»тЅЇуФ»т║ћућетцёуљєтѕ░уггтЄаТЅ╣ТЋ░ТЇ«С╣ІтљјСИЇтєЇтцёуљєуЏ┤ТјЦУ┐ћтЏъ№╝їтюеУ┐ЎТаиуџёТЃЁтєхСИІ№╝їТЪЦУ»бтЁХт«ъСИЇжюђУдЂтєЇу╗Ду╗ГТЅДУАї№╝їУ┐ЎТЌХCNС╝џСИІтЈЉСИђСИфEnd queryС┐АтЈи№╝їуёХтљјтюет╣ХУАїТЅДУАїТхЂуеІСИіС╣ЪС╝џтЈіТЌХтЊЇт║ћУ┐ЎСИфС┐АтЈиТЮЦу╗ЊТЮЪТЪЦУ»бсђѓСИІтЏЙт░▒Тў»у«ђтЇЋуџёт▒Ћуц║сђѓ

тидСИІУДњТў»тѕєжАхтю║ТЎ»СИІуџёТЅДУАїТђДУЃйт»╣Т»ћсђѓТюђтидУЙ╣уџёУ┐ЎСИфТЪ▒тГљТўЙуц║уџёТў»№╝їтдѓТъюУ┐ЎСИфТЪЦУ»бтюеТГБтИИТЅДУАїТЃЁтєхСИІ№╝їтюеУ┐ћтЏъуггСИђТЮАу╗ЊТъюуџёТЌХтђЎТЅђжюђУдЂуџёТЌХжЌ┤№╝їуггС║їСИфТЪ▒тГљТў»тдѓТъюУ«Йуй«С║єfetch sizeТў»1000ТЮАТЌХ№╝їт«ЃТЅђжюђУдЂТЅДУАїуџёТЌХжЌ┤сђѓтдѓТъюТ▓АТюЅУ«Йуй«fetch size№╝їтюеС╝ау╗ЪуџёТЅДУАїТќ╣т╝ЈСИІ№╝їУ┐ЎСИфТЪЦУ»буџёТЅДУАїТЌХжЌ┤Тў»жЮътИИжЋ┐уџё№╝їСйєтдѓТъюТѕЉС╗гтЁѕУ«Йуй«У┐ћтЏъ1000ТЮАу╗ЊТъю№╝їУ┐ЎСИфТЪЦУ»бТЌХжЌ┤тЈ»С╗ЦтцДт╣Ёу╝Ет░ЈсђѓтљїТЌХтюеу╗Ду╗ГТЅДУАїуџёТЌХтђЎ№╝їтљју╗ГуџёТ»ЈСИђТЅ╣уџёТЪЦУ»бу╗ЊТъюуџёТЅДУАїТЌХжЌ┤тЄаС╣јтЈ»С╗Цт┐йуЋЦСИЇУ«АсђѓтЏаСИ║тЅЇуФ»тюеТјЦтЈЌТЪЦУ»бТЌХ№╝їТѕЉС╗гтљјуФ»С╣ЪтюетљїТЌХтцёуљєу╗Ду╗ГУјитЈќТЪЦУ»бу╗ЊТъюсђѓ

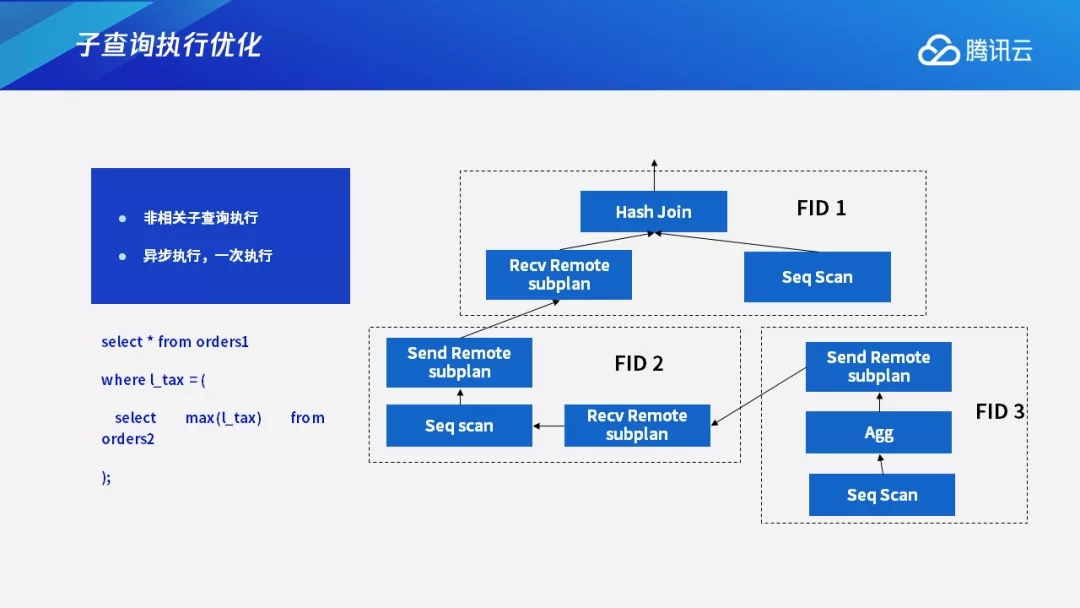

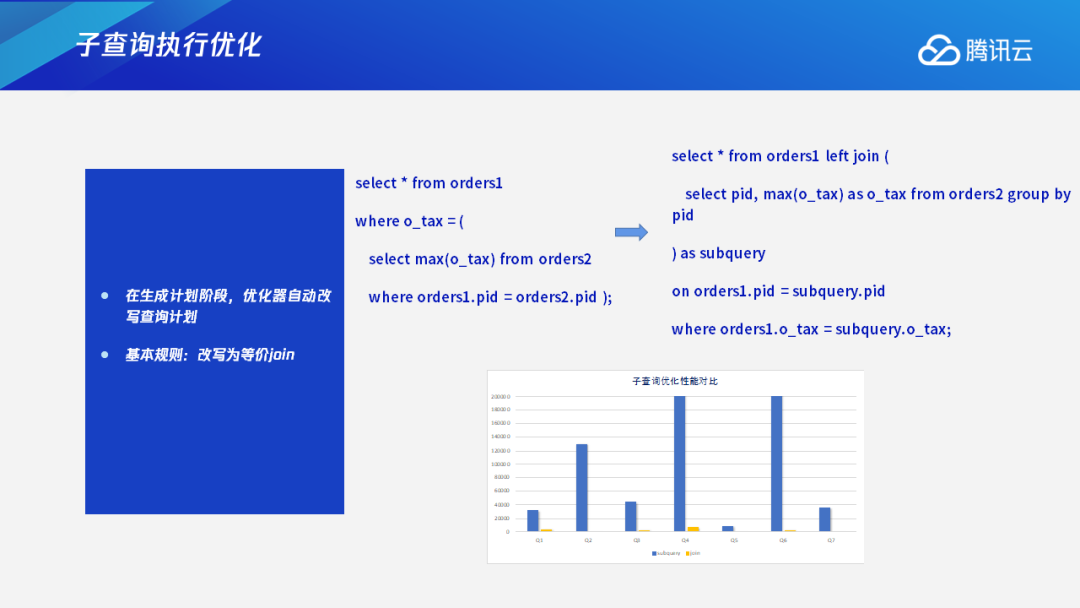

тЏЏсђЂтГљТЪЦУ»бТЅДУАїС╝ўтїќ

тюеOLAPтю║ТЎ»СИІСИђС║ЏТ»ћУЙЃтЁИтъІуџётїЁтљФТюЅтГљТЪЦУ»буџёТЅДУАїС╝ўтїќсђѓOLAPтГљТЪЦУ»бтЪ║ТюгСИітЈ»С╗ЦтѕєСИ║СИцу▒╗№╝џСИђу▒╗Тў»жЮъуЏИтЁ│уџётГљТЪЦУ»б№╝їСИђу▒╗Тў»уЏИтЁ│уџётГљТЪЦУ»бсђѓ

4.1 жЮъуЏИтЁ│тГљТЪЦУ»бТЅДУАї

жЮъуЏИтЁ│уџётГљТЪЦУ»б№╝їТїЄуџёТў»тГљТЪЦУ»буџёу╗ЊТъюжЏєТў»СИђСИфтЏ║т«џуџётђ╝№╝їУиЪтцќт▒ѓуџёТЪЦУ»бТ▓АТюЅтЁ│УЂћсђѓт»╣жЮъуЏИтЁ│тГљТЪЦУ»б№╝їТѕЉС╗гУ«ЙУ«АС║єРђют╝ѓТГЦТЅДУАїсђЂСИђТгАТЅДУАїРђЮуџёТю║тѕХсђѓтГљТЪЦУ»бт»╣ТѕЉС╗гуџёТЅДУАїТАєТъХТЮЦУ»┤№╝їТў»тЈдтцќуџёСИђСИфтѕєуЅЄ№╝їт«ЃУиЪуѕХТЪЦУ»бтЈ»С╗Цт╣ХУАїТЅДУАїсђѓтйЊуѕХТЪЦУ»бжюђУдЂтГљТЪЦУ»буџёу╗ЊТъюТЌХ№╝їтГљТЪЦУ»бти▓у╗ЈТЅДУАїт«їТ»ЋС║є№╝їуѕХТЪЦУ»бтЈ»С╗ЦуЏ┤ТјЦУјитЈќу╗ЊТъюу╗Ду╗ГТЅДУАїсђѓ

СИІтЏЙСИГ№╝їFID 3тѕєуЅЄт░▒Тў»С╗БУАетГљТЪЦУ»буџёТЅДУАїтѕєуЅЄсђѓHash JoinтюеТЅДУАїУ┐ЄуеІСИГ№╝їТ»ЈСИфтѕєуЅЄжЃйТў»т╣ХУАїТЅДУАїуџё№╝їтюеFID 2тЂџТЅФТЈЈуџёТЌХтђЎ№╝їтдѓТъют«ЃСИЇжюђУдЂтГљТЪЦУ»буџёу╗ЊТъю№╝їт░▒тЈ»С╗ЦСИЇућеуГЅтЙЁFID 3уџёТЅДУАїу╗ЊТъюсђѓтйЊт«ЃжюђУдЂтГљТЪЦУ»буџёТЅДУАїу╗ЊТъюТЌХ№╝їтЏаСИ║FID 3тњїFID 2Тў»т╣ХУАїТЅДУАї№╝їт░▒тЈ»С╗ЦуЏ┤ТјЦУјитЈќтѕ░У┐ЎСИфу╗ЊТъют╣ХСй┐ућесђѓУ┐ЎТў»жЮъуЏИтЁ│тГљТЪЦУ»буџёТЅДУАїсђѓ

4.2 уЏИтЁ│тГљТЪЦУ»бТЅДУАї

ТЏ┤СИ║тцЇТЮѓуџёТў»уЏИтЁ│тГљТЪЦУ»буџёТЅДУАїсђѓтюеТЅДУАїУ┐ЄуеІСИГ№╝їуЏИтЁ│тГљТЪЦУ»буџёТЅДУАїу╗ЊТъюТў»УиЪуѕХТЪЦУ»буџёС╝ажђњТЮАС╗ХТў»ТюЅтЁ│у│╗уџёсђѓ

С╗ЦСИІтЏЙСИ║СЙІ№╝їтюеorder 1тњїorder 2уџёpidТў»уЏИуГЅуџёТЃЁтєхСИІ№╝їТЪЦУ»бС╝џС╗јorder 2У┐ЎСИфУАеСИГтЈќтЄ║ТюђтцДуџёtaxтђ╝сђѓУ┐ЎСИфtaxуџётђ╝тєЇтњїтцќт▒ѓуџёorder 1уџёtaxтђ╝тЂџуГЅтђ╝Т»ћУЙЃ№╝їТюђтљјУјитЈќуГЅтђ╝Т»ћУЙЃТѕљуФІуџёжѓБСИфу╗ЊТъю№╝їСйюСИ║Тюђу╗ѕуџёТЪЦУ»бу╗ЊТъюсђѓ

уЏИтЁ│тГљТЪЦУ»буџёТЅДУАї№╝їСИђУѕгТЃЁтєхТў»ућ▒уѕХтѕєуЅЄС╝ажђњтЈѓТЋ░тѕ░тГљтѕєуЅЄСИі№╝їтГљтѕєуЅЄС╝џУ«Йуй«У┐ЎСИфтЈѓТЋ░тђ╝№╝їуёХтљјУ┐ћтЏъТЪЦУ»бу╗ЊТъюсђѓТ»ћтдѓFID 2тЁѕтЂџСИђСИфscanуџёТЊЇСйю№╝їт«ЃтюеУдЂУјитЈќтГљТЪЦУ»буџётђ╝ТЌХ№╝їС╝џтЁѕТііorder 1уџёpidтЁѕжђџУ┐ЄfragmentС╣ІжЌ┤уџёУ┐ъТјЦС╝ажђњу╗ЎFID 3№╝їFID 3тюетЈќтЙЌт╣ХУ«Йуй«С║єorder 1уџёpidтђ╝тљј№╝їТЅДУАїт«ЃТюгУ║ФуџёТЅДУАїУ«Атѕњ№╝їТюђтљјУјитЈќуџёу╗ЊТъютєЇС╝ажђњу╗ЎFID 2№╝їуёХтљјFID 2УјитЈќу╗ЊТъютљјтєЇу╗Ду╗ГУ┐ЏУАїУ«Ау«Ќ№╝їтЈ»С╗ЦуюІтѕ░У┐ЎТў»СИђСИфжЮът╣ХУАїуџёТЅДУАїсђѓС╣ІТЅђС╗ЦУ┐ЎТаи№╝їСИ╗УдЂТў»тЏаСИ║тГљТЪЦУ»бFID 3уџёТ»ЈСИђТЮАТЅДУАїу╗ЊТъютЁХт«ъТў»тњїFID 2СИІтЈЉуџётЈѓТЋ░тђ╝Тў»ТюЅтЁ│уџёсђѓтЏаТГцт«ЃС╗гС┐ЕСИЇУЃйт╣ХУАїТЅДУАї№╝їУ┐ЎТаиуџётГљТЪЦУ»бТЅДУАїТЋѕујЄт░▒Т»ћУЙЃСйјсђѓ

жњѕт»╣У┐ЎуДЇТЃЁтєх№╝їТѕЉС╗гтЂџС║єуЏИтЁ│тГљТЪЦУ»буџёС╝ўтїќ№╝їС╝џтюеУ«АтѕњућЪТѕљжўХТ«хућ▒С╝ўтїќтЎеУЄфтіеТћ╣тєЎТЪЦУ»бУ«АтѕњсђѓтюетЙѕтцџт║ћућеСИГ№╝їТЪЦУ»бУ»ГтЈЦтЈ»УЃйТў»ућ▒тЅЇуФ»т║ћућеУЄфтіеућЪТѕљуџё№╝їт╣ХСИћТЋ░жЄЈтЙѕтцД№╝їтдѓТъюжЃйућеС║║тиЦТЮЦУ┐ЏУАїС╝ўтїќТћ╣тєЎ№╝їтиЦСйюжЄЈС╝џжЮътИИтцДсђѓтюеУ┐ЎуДЇТЃЁтєхСИІ№╝їТѕЉС╗гтюеС╝ўтїќтЎеСИГт«ъуј░С║єСИђтЦЌтЪ║С║јС╗БТЋ░тЈўТЇбУДётѕЎуџёУЄфтіеТћ╣тєЎ№╝їС╝џТііуЏИтЁ│тГљТЪЦУ»б№╝їТа╣ТЇ«СИђт«џуџёУДётѕЎТћ╣тєЎТѕљуГЅС╗иуџёJoinТЪЦУ»б№╝їС╣ІтљјтєЇУ┐ЏУАїтЁХС╗ќС╝ўтїќ№╝їућЪТѕљТюђтљјуџёТЪЦУ»бУ«Атѕњсђѓ

у╗ЈУ┐ЄС╝ўтїќтљј№╝їуЏИтЁ│тГљТЪЦУ»буџёТђДУЃйТЈљтЇЄжЮътИИТўјТўЙсђѓСИІжЮбУ┐ЎСИфтЏЙт░▒Тў»тюетГљТЪЦУ»бТћ╣тєЎС╣Ітљј№╝їт«ЃуџёС╝ўтїќТђДУЃйт»╣Т»ћсђѓтЈ»С╗ЦуюІтѕ░№╝їтдѓТъюТїЅуЁДтјЪТЮЦуџёТЅДУАїТќ╣т╝Ј№╝їТ»ЈСИфтГљТЪЦУ»бТ»ЈСИђТгАУ«Йуй«тЈѓТЋ░С╣ІтљјжЃйжюђУдЂТЅДУАїСИђТгА№╝їТЋ┤СИфТЪЦУ»буџёТЅДУАїТЌХжЌ┤жЮътИИжЋ┐сђѓтдѓТъюТћ╣тєЎТѕљуГЅС╗иуџёJoinТЪЦУ»бС╣Ітљј№╝їт«ЃуџёТЅДУАїТЋѕујЄжЮътИИжФўсђѓ

- тдѓСйЋтюеiPhoneСИіт┐ФжђЪТЅЙтѕ░TikTokтЦйтЈІ№╝ЪУ┐ЎСИцСИфу«ђтЇЋТќ╣Т│ЋУй╗ТЮЙТљът«џ№╝Ђ

- тЏйтєЁућеТѕитдѓСйЋСИІУййтњїСй┐ућеTikTok№╝ЪУІ╣Тъютњїт«ЅтЇЊУ«ЙтцЄТюЅСИЇтљїУдЂТ▒ѓтљЌ№╝Ъ

- СИ╗У┤дтЈиСИјтЅ»У┤дтЈитдѓСйЋжЁЇтљѕуЏ┤ТњГ№╝ЪТЈГуДўтцДтЈиу▓ЅСИЮтбъжЋ┐уџёуДўУ»ђ№╝Ђ

- TikTokУй»Уи»ућ▒уюЪуџёТюЅт┐ЁУдЂтљЌ№╝ЪтдѓСйЋУ«ЕСйауџёуйЉжђЪТ»ћтѕФС║║т┐Ф№╝Ъ

- тЏйтєЁТЌаТ│ЋТГБтИИСй┐ућеTikTok№╝ЪУ┐ЎС║ЏУ«Йуй«СйауЪЦжЂЊС║єтљЌ№╝Ъ

- TikTokтИдУ┤ДТЮЃжЎљтдѓСйЋућ│У»и№╝ЪтЋєтЊЂТЕ▒уфЌУй╗ТЮЙтЈўуј░№╝їСйатГдС╝џС║єтљЌ№╝Ъ

- СИ║С╗ђС╣ѕтЏйтєЁтй▒УДєтЅфУЙЉСИЇУхџжњ▒С║є№╝ЪTikTokУЃйтљдТѕљСИ║СйауџёСИІСИђСИфУхџжњ▒тѕЕтЎе№╝Ъ

- TikTokуЪГУДєжбЉтИдУ┤ДТђјТаиТЅЇУЃйТюѕУхџ20СИЄ№╝Ът░ЈтЏбжўЪтдѓСйЋт┐ФжђЪт«ъуј░жФўТћХуЏі№╝Ъ